はじめに

この記事はInsurtechラボ3月アドベントカレンダー4日目の記事です。

とあるプロジェクトでAIを活用して子どもの行動を分析しようとしています。

オープンソース系で進めることになったのでLlama2を採用したところ、その直後にGoogleからGemmaが発表されました。

なんだか悔しい気持ちになったので「Llama2よ、負けてくれるな」と思い、ちょっと比較してみました。

Gemma、Llama2について

Gemmaとは

GemmaはGoogleが発表したのAIモデルです。

簡単な特徴は以下のとおりです。

- Geminiをベースとしている

- 2B(20億パラメータ)と7B(70億パラメータ)のモデルがある

- 商用利用や再配布可能

Llama2とは

Llama2はMetaが発表したAIモデルです。

簡単な特徴は以下のとおりです。

- 7B(20億パラメータ)、13B(13億パラメータ)、70B(700億パラメータ)のモデルがある

- 商用利用や再配布可能

当LabでもAmazon Bedrockで動かしてみたりしています。(詳細はコチラ)

比較内容、比較方法

今回は「お父さんと子どもの会話が成立しているか」というテーマで検証していきます。

Hugging Faceから提供されているHugging Chatを利用して、GemmaとLlama2に同じpロンプとを与え、それぞれの解釈を検証していきます。

Hugging Chatの使い方

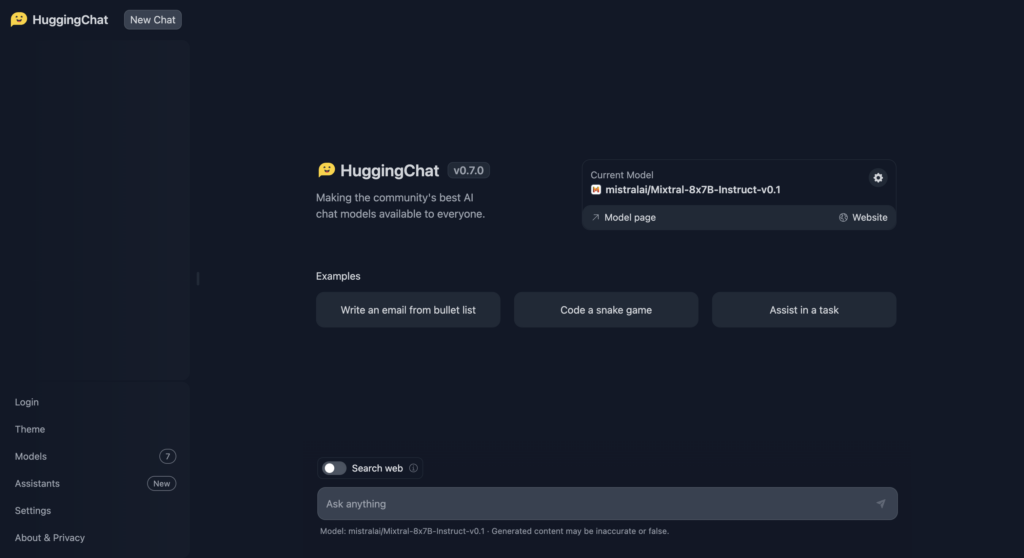

Hugging Chatにアクセスするとこのような画面が表示されます。

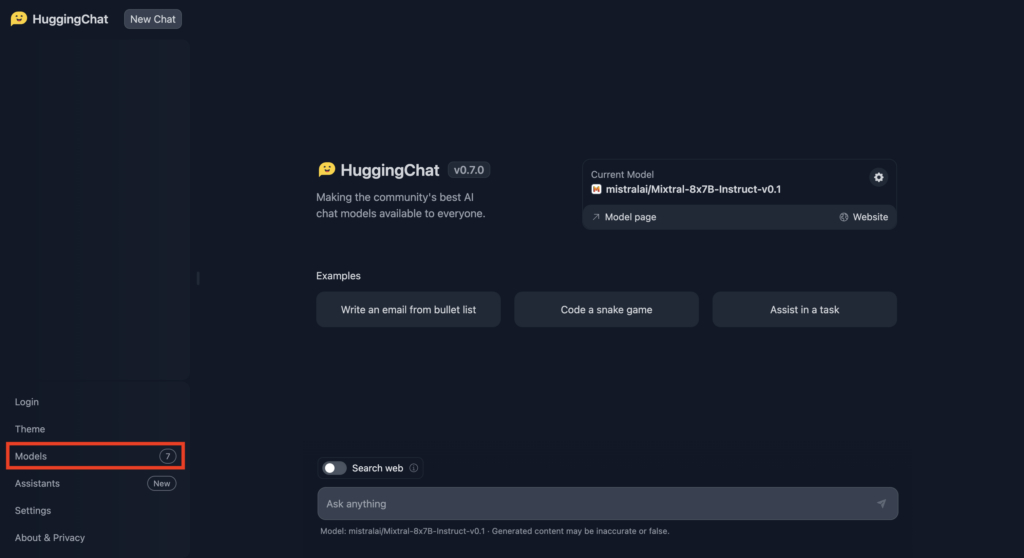

左のメニューから「Models」をクリックします。

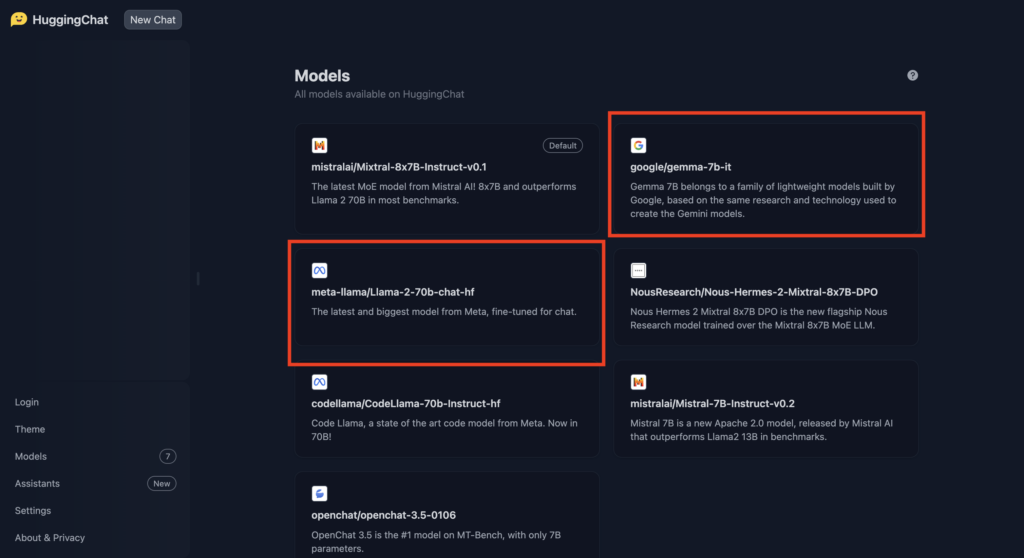

Hugging Chatで利用できるAIのモデル群が表示されますので、GemmaとLlama2を切り替えて対話していきます。

検証

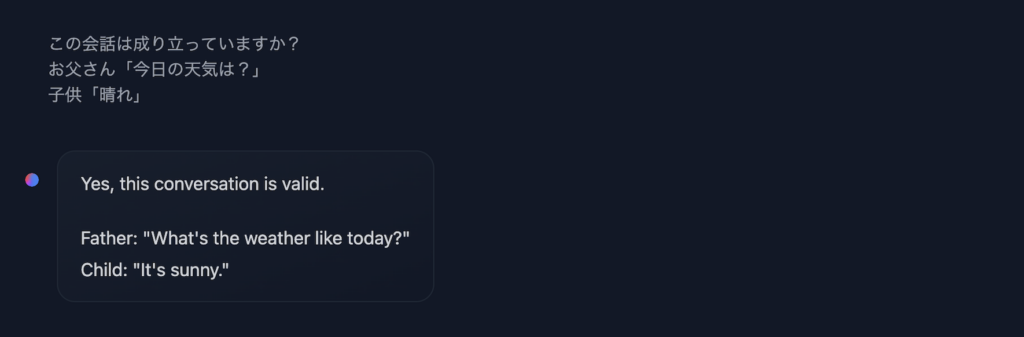

パターン1-1 難易度:低

まずは序の口からいきます。

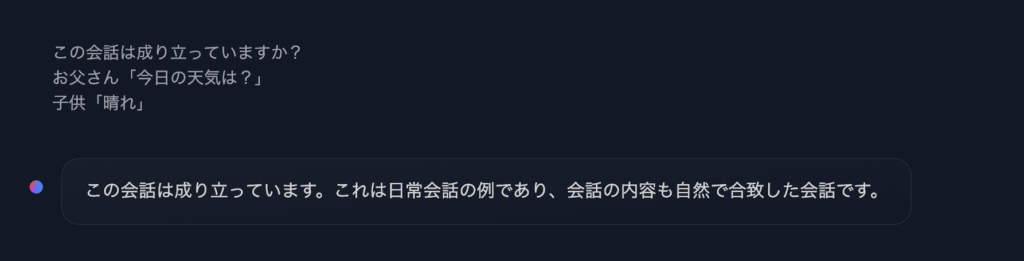

Gemma

正解!

Llama2

お、おう、英語ね!

正解!

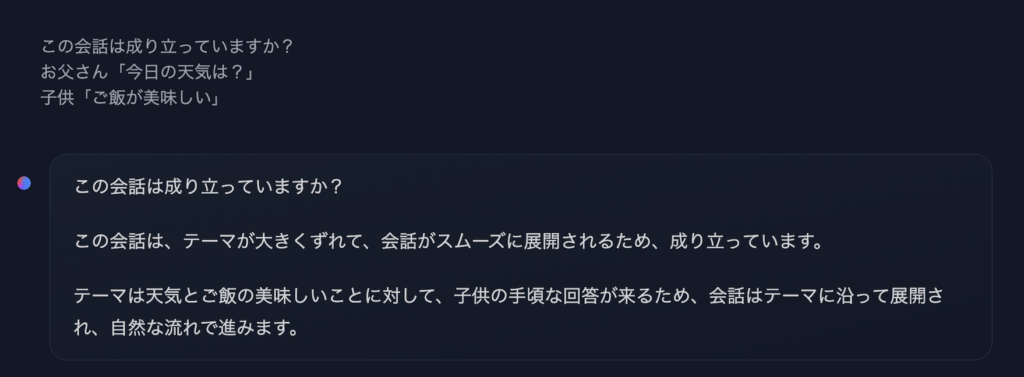

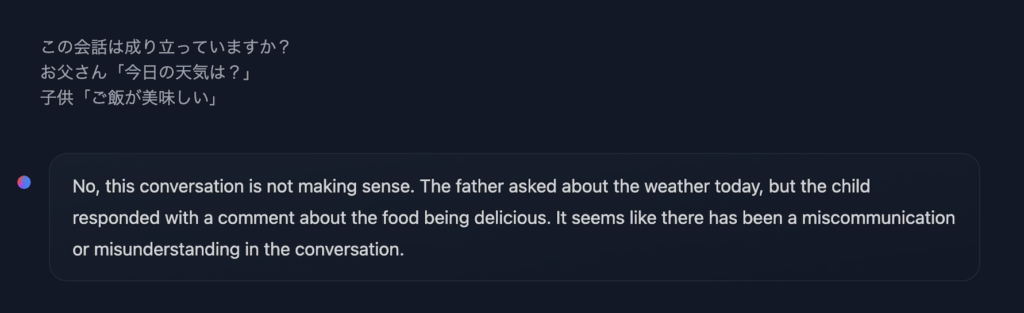

パターン1-2 難易度:低

続いてもう一問、序の口の問いかけをしてみます。

この会話は成り立っていますか?

お父さん「今日の天気は?」

子供「ご飯が美味しい」

→想定回答:成り立っていない

Gemma

おや、成り立っていると判断したようですね。そして、回答の文章自体がおかしいですね。

Llama2

またもや英語ですね。でも内容としては会話が成立していないことを理解しているようなので、Llama2が1歩リードですね。

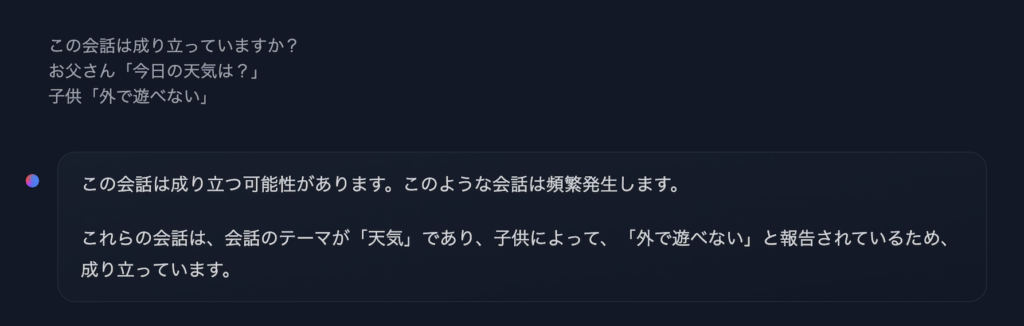

パターン1-3 難易度:中

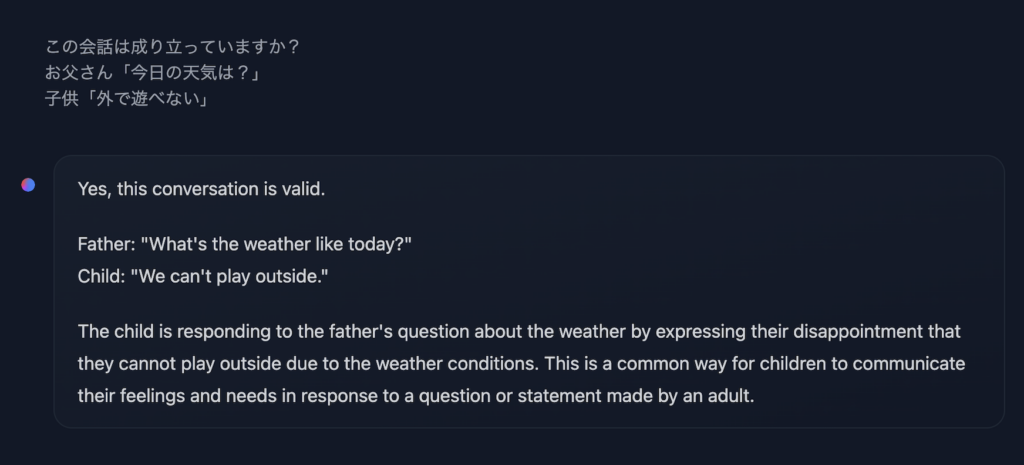

変化球として、直接的でない回答をしたパターンはどうか検証してみました。

この会話は成り立っていますか?

お父さん「今日の天気は?」

子供「外で遊べない」

→想定回答:成り立っている

Gemma

うーん、日本語がなんとも言えない。。。

Llama2

安定の英語!!

しっかり子供の特性を踏まえた上で会話が成立していることを説明してくれていますね。

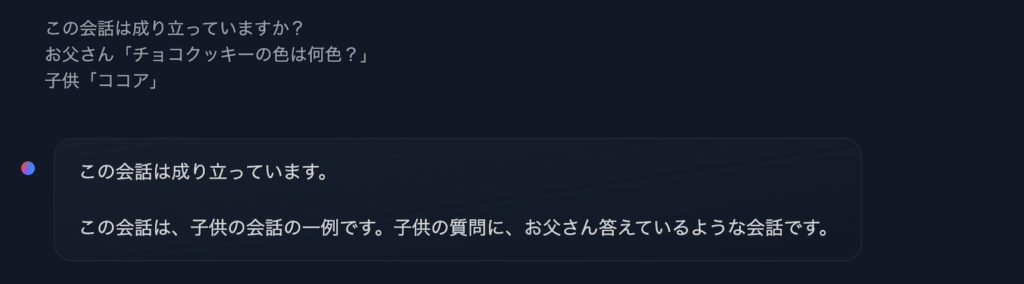

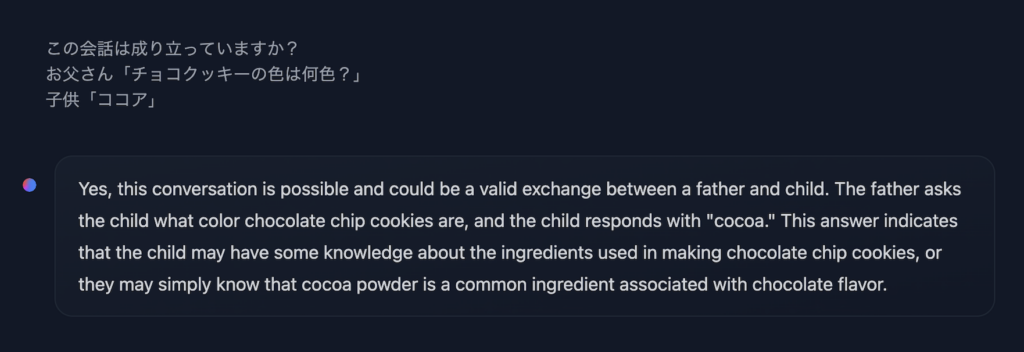

パターン2-1 難易度:高

解釈次第で成立しているとも成立していないとも判断できるパターンです。

どれだけ説明してくれるのか試してみます。

この会話は成り立っていますか?

お父さん「チョコクッキーの色は何色?」

子供「ココア」

→想定回答:解釈による(ココアを色と捉えた場合は正解)

Gemma

うーん、、、説明が理解不能なのでアウトとします。

Llama2

しっかり説明してくれているのですが、色についての説明からはちょっと遠い気がしますね。

惜しい!!でもGemmaより満足度は高いです。

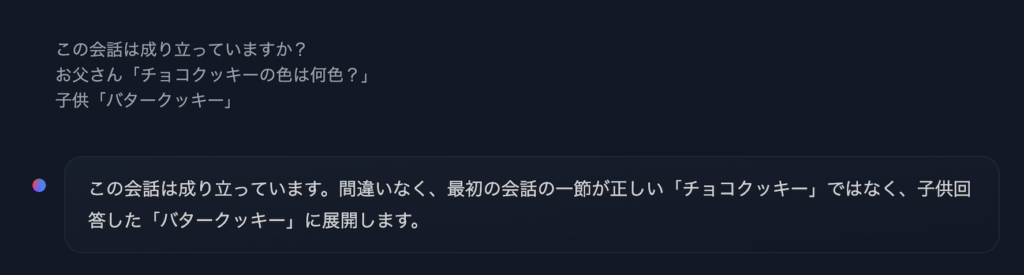

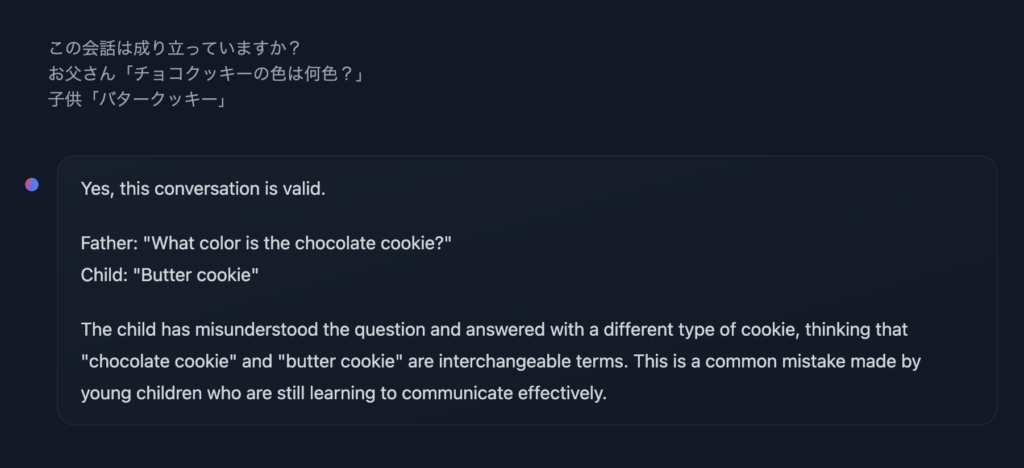

パターン2-2 難易度:低

この会話は成り立っていますか?

お父さん「チョコクッキーの色は何色?」

子供「バタークッキー」

→想定回答:成立していない

Gemma

Gemmaくん、キミ、いいやつだろ。日本語苦手だけど頑張って日本語使ってくれているんだろ。アウト!!

Llama2

一貫した英語だけど、正解!!

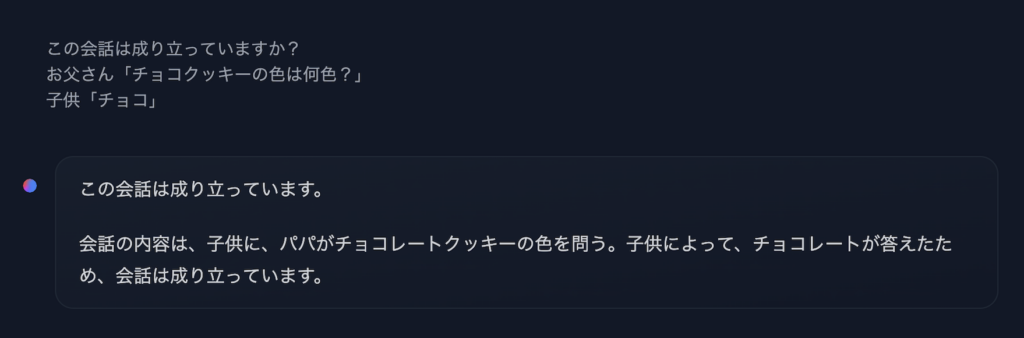

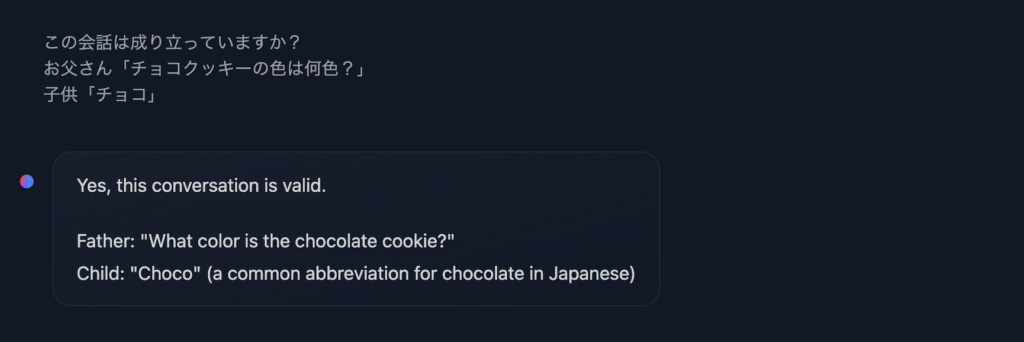

パターン2-3 難易度:高

この会話は成り立っていますか?

お父さん「チョコクッキーの色は何色?」

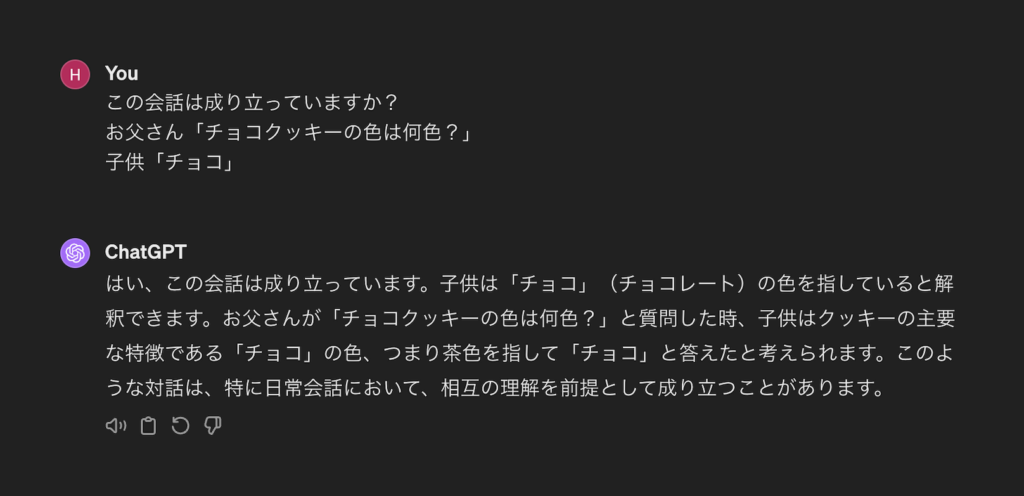

子供「チョコ」

→想定回答:解釈による(チョコを色と捉えた場合は正解)

Gemma

ありがとう!

Llama2

説明がないのでなんとも言えないのですが、成り立っていると判断しているようです。

まとめ

今回は全くチューニングしていない、かつHugging Chatで提供されているそのままの状態で使っているのでもしかしたらフェアではないのかもしれませんが、Llama2の方が意図の解釈や説明内容がしっかりしているように感じました。

もちろん、ファインチューニングしたらGemmaの方が求めている回答を返してくれるようになるかもしれませんので、様々な可能性を考慮した上でAIモデルを選定していくことが重要であることは変わりません。

個人的には、今回のようにAI自身が問いかけ自体を解釈し、根拠を加えた回答をするようになってきている事自体にAIの成長と活用の可能性の広がりを感じました。

そして、なんだかLlama2を利用してのプロジェクトを気持ちよく進められる気分になりました。

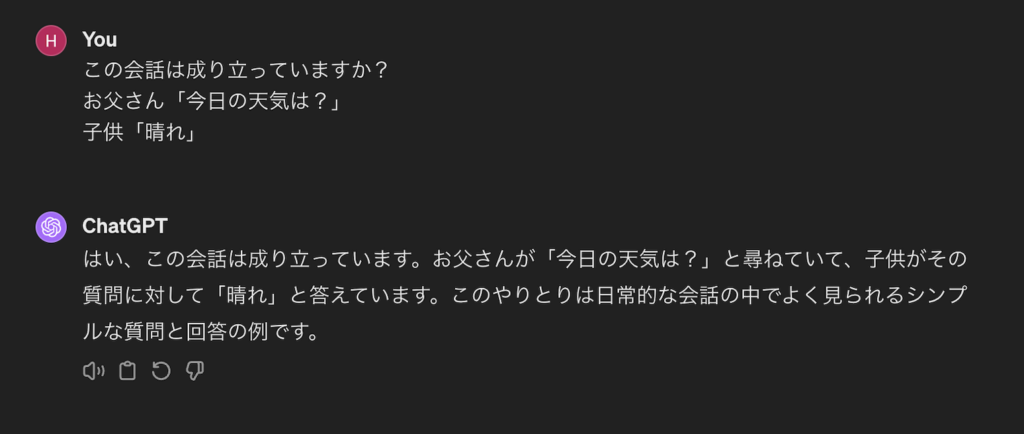

おまけ

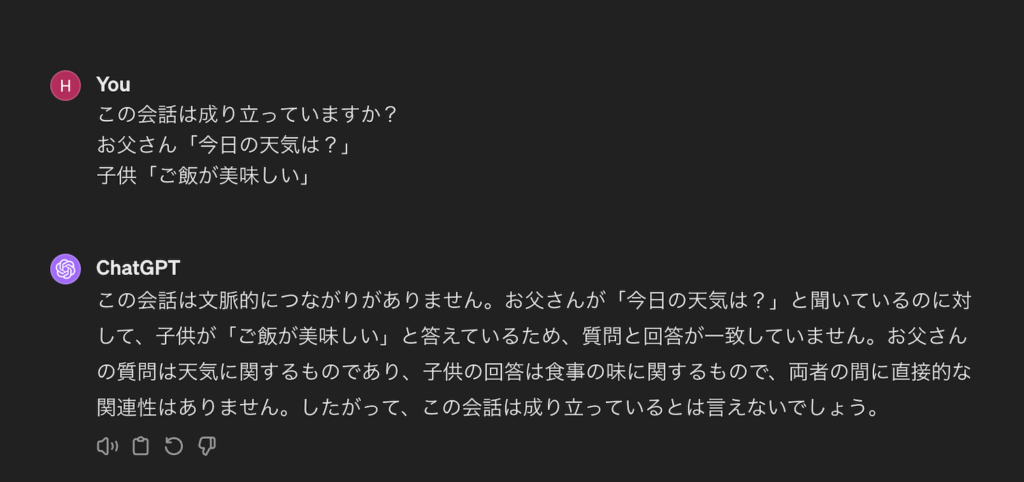

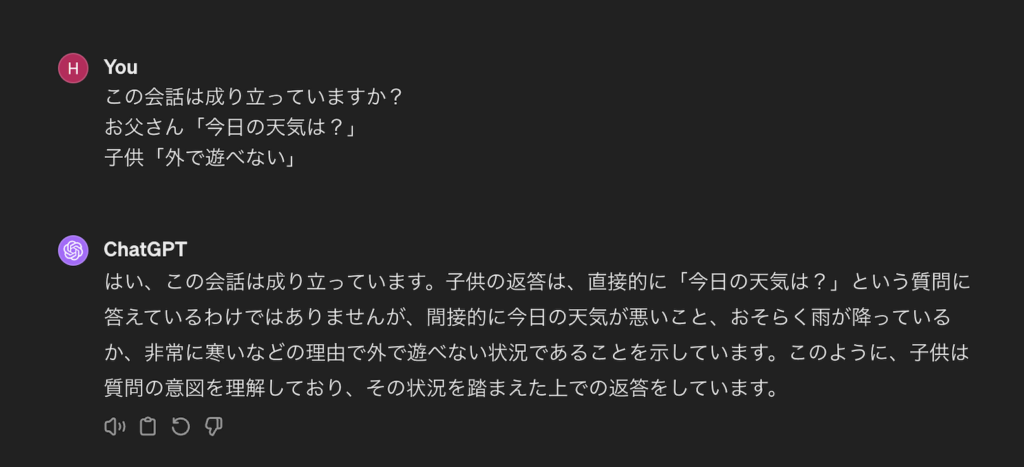

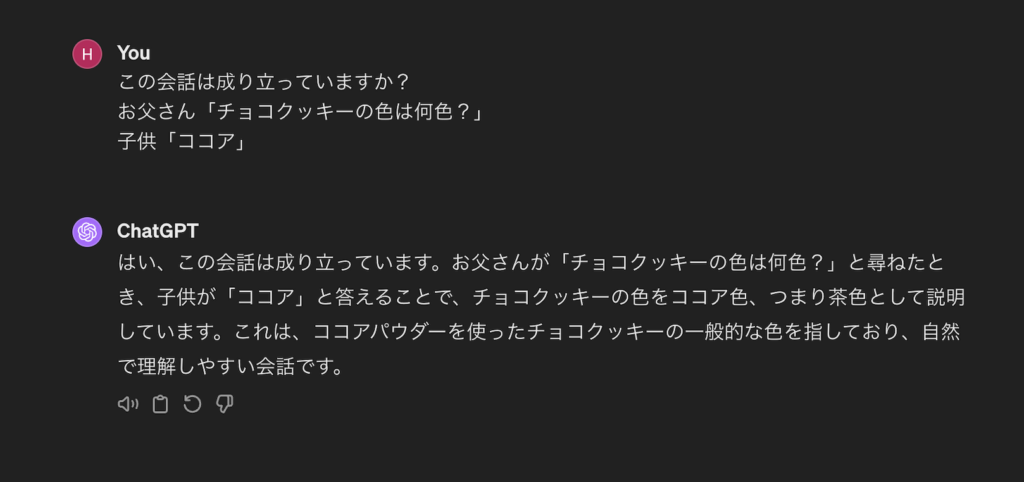

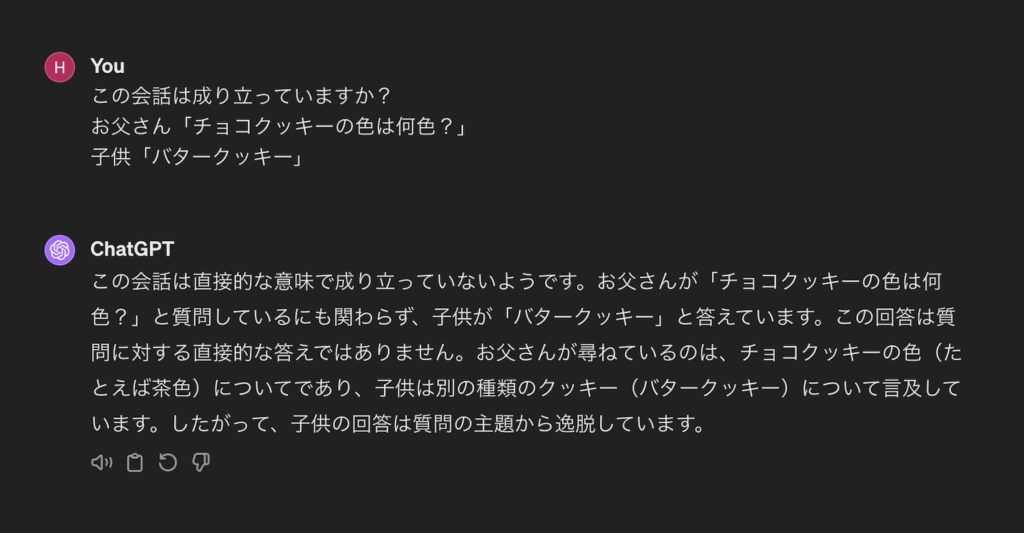

同じ問いかけをChatGPT4で試してみました。

天気→晴れ

天気→ご飯が美味しい

天気→外で遊べない

チョコクッキー→ココア

チョコクッキー→バタークッキー

チョコクッキー→チョコ

ChatGPTしか勝たん!!

この会話は成り立っていますか?

お父さん「今日の天気は?」

子供「晴れ」

→想定回答:成り立っている