Anthropic社がAIチャット「Claude 2」が2023/10/16(現地時間)から日本でも利用できるようになったそうですね。

今まではAmazon Bedrock経由で東京リージョンから唯一使える軽量版のClaude Instant v1.2を従量課金にビクビクしながら使っていたのですが、なんと本家には無料枠があると!

これは使うしかないという訳で、本家のClaude 2使ってみたです。

Claude 2とは?

公式:https://www.anthropic.com/index/claude-2

長かったので、Bing Chatに要約してもらいました(便利!)。

~~~~~要約 ここから~~~~~

Anthropicが開発したAIチャットボットであるClaude 2は、2023年7月11日にリリースされました。以下はClaude 2の特徴です:

- 一度に多数のプロンプトを処理できます。最大10,000トークンまたは約75,000単語まで。

- 高い精度で安全な回答を出力します。

- 高いコーディングスキルを持ち、印象的なコーディングや数学を実行できます。

- 2023年初頭までのデータでトレーニングされており、他のAIチャットボットと比較して比較的新しいです。

- 複数のファイルを読み込むことができ、完全に無料で使用することができます。

~~~~~要約 ここまで~~~~~

公式ページでは米国と英国でしか利用できないとありますが、内容古いかもしれません。

元OpenAIの人たちが作っているだけあってChatGPTの苦手としているもの(長いプロンプト、「憲法AI」による有害なアウトプットの回避、最新のトレーニングデータなど)にも取り組んでいます。非常に注目されているAIのようです。

Claude 2を使うまでの流れ

下記にある画面ショットや抜粋した文章は、2023/10/21時点のものです。オープンベータという位置付けなので、今後変更される可能性があるのでご注意ください。

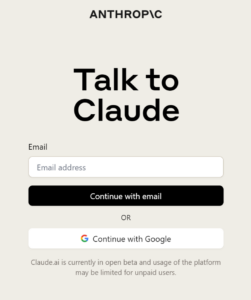

Sign up

無料版であってもユーザ登録が必要です。ログイン画面を開きます。

ここでは「Continue with Google」で入りました。

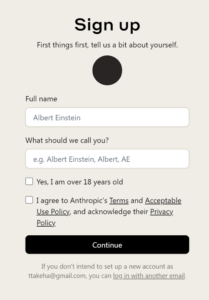

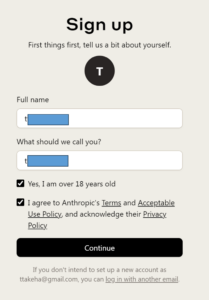

Googleで認証が終わると、下記のようなSign up画面が出てきます。

Full name、What should we call you?などに入力していきます。

おそらく、What should we call you?に「t」で始まる名前を入れたので、画面上部に「T」と出ているのだと思います。

18歳未満は利用できないようです。Privacy Policyにも書かれています。

9. Children

Our Services are not directed towards, and we do not knowingly collect any information of, children under the age of 18. If you become aware that a child under the age of 18 has provided any personal data to us while using our Services, please email us at privacy@anthropic.com and we will investigate the matter and, if appropriate, delete the personal data.

(日本語訳)

当社のサービスは、18歳未満の児童を対象としておらず、18歳未満の児童の情報を意図的に収集することもありません。当社のサービスの利用中に、18歳未満の児童が当社に個人データを提供したことに気付いた場合は、privacy@anthropic.com まで電子メールでご連絡ください。当社でその問題を調査し、適切であれば個人データを削除します。

18歳超えチェックと「Term」「Acceptable Use Policy」「Privacy Policy」同意チェックをして「Continue」ボタンを押下します。

Termなどの利用規約に面白いなーと思う箇所があったので、後で紹介します。

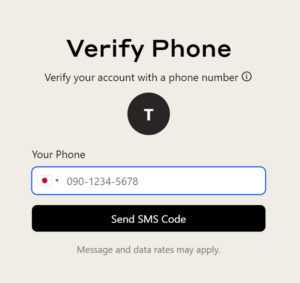

SMS認証

SMS認証が必要なようです。「Your Phone」から日本を選び、電話番号を入力します。

すると、SMSに6桁の認証コードが送られてくるので、それを画面に入力します。

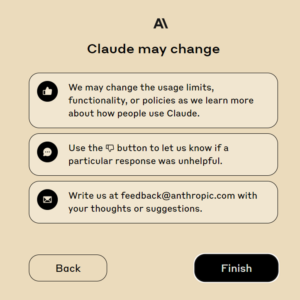

注意事項を読む

SMS認証が通ればあともう少しです。注意事項が次々と出力されるので、よく読みましょう。

Nextを押下します。

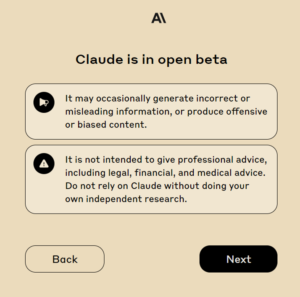

Claudeはまだオープンベータでしたか。すごく丁寧に説明していますね。

(日本語訳)

時として、不正確または誤解を招く情報を生成したり、攻撃的または偏ったコンテンツを生成する可能性があります。法的、財政的、医学的な助言を含む専門的な助言を与えることを意図したものではありません。ご自身で独自に調査することなく、Claudeに依存しないでください。

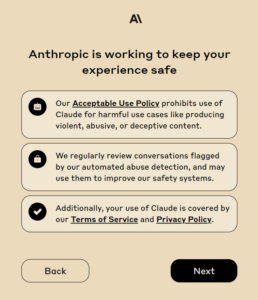

安全に関する注意事項です。すごく慎重です。

(日本語訳)

私たちのAcceptable Use Policyは、暴力的、虐待的、または欺瞞的なコンテンツを作成するような有害な使用例に対するClaudeの使用を禁止しています。当社では、自動不正使用検出機能によってフラグが立てられた会話を定期的に確認し、当社の安全システムを改善するために使用することがあります。

さらに、お客様の Claude のご利用には、当社のサービス利用規約およびプライバシーポリシーが適用されます。

変更の可能性について。オープンベータだし、激変するでしょう。

(日本語訳)

利用者のClaudeの使用方法についての詳細が判明した場合、利用制限、機能、またはポリシーを変更することがあります。特定の回答が役に立たなかった場合は、Badボタンを使ってお知らせください。

ご意見・ご要望は feedback@anthropic.com まで。

そういえば、(全然関係ありませんが)open-interpreterというOSSがあって0.1.3の頃(9/22)に飛びついて遊び、最新の0.1.10(早)を適用したら全く動かなくなりました。正式リリースされていないもが激変するのなんて当たり前なので、楽しむ気持ちが大事ですよね。

という訳で、ようやく完了です!

(補足)利用規約、利用規定、プライバシーポリシーについて

Sign upするときに読んだ「Term」「Acceptable Use Policy」「Privacy Policy」に興味深い記述がありました。ここまで書くのか!と思ったものがあったのでメモしておきます。

生成物使用の許可:Termより

「6. Prompts, Outputs, and Materials」より抜粋

a. Rights to Materials. Our Services may allow you to submit text, documents, or other materials to the Services for processing (“Prompts”). Our Services may generate responses based on your Prompts (“Outputs”). Outputs and Prompts collectively are “Materials.” You represent and warrant that you have all rights, and have provided any notices and obtained any consents, that are necessary for us to process any Prompts you submit to the Services in accordance with our Terms. You also represent and warrant that your submission of Prompts to us will not violate our Terms, our Acceptable Use Policy, or any laws applicable to those Prompts—including intellectual property laws and any privacy or data protection laws governing personal information contained in your Prompts. Except as expressly provided in our Terms, you retain all right, title, and interest—including any intellectual property rights—that you have in and to your Prompts. Subject to this Section 6(a) and without limiting Section 12, we authorize you to use the Outputs for the Permitted Use.

(日本語訳)

a. マテリアルに対する権利。当社のサービスでは、お客様がテキスト、文書、またはその他のマテリアルを処理のために本サービスに提出することができます(以下「プロンプト」といいます)。当社サービスは、お客様の「プロンプト」に基づいて回答(「アウトプット」)を生成する場合があります。アウトプットとプロンプトは総称して “マテリアル” です。お客様は、本規約に従ってお客様が本サービスに提出したプロンプトを当社が処理するために必要なすべての権利を有していること、およびあらゆる通知を提供し、あらゆる同意を得ていることを表明し、保証するものとします。また、利用者は、利用者が当社に送信するプロンプトが、当社の利用規約、利用規定、またはプロンプトに適用される法律(知的財産権法、および利用者のプロンプトに含まれる個人情報を管理するプライバシー法またはデータ保護法を含む)に違反しないことを表明し、保証するものとします。当社規約で明示的に規定されている場合を除き、お客様は、お客様の「プロンプト」に関して有するすべての権利、権原、および利益(知的財産権を含む)を保持します。本第6条(a)に従い、また第12条を制限することなく、当社は、許可された使用のために出力物を使用することをお客様に許可します。

つまり、プロンプトとして権利者から同意を得ないものは入力してはダメだし、その内容は利用規約や法律に違反していないこと、を満たさないと出力されたものを使うのは許さん!ということでしょうか。

例えば、ネットから著者の許可を得ずに本の内容をコピペして、それを元に別の著作物をAIに生成させたとしたら、その出力物は「許可しません」ということです。たしかに。

入力したプロンプトの権利を我々が持っていることも明文化されていますね。

他の生成AIの利用規約にも書かれていたのかな?真剣に読んだことなかった気がする・・・

入力された情報を機械学習に利用するか?:Termより

「6. Prompts, Outputs, and Materials」より抜粋

e. Our Use of Materials. We may use Materials to provide, maintain, and improve the Services and to develop other products and services. We will not train our machine learning models on any Materials that are not publicly available, except in two circumstances:

If you provide Feedback to us (through the Services or otherwise) regarding any Materials, we may use that Feedback in accordance with Section 11.

If your Materials are flagged for trust and safety review, we may use or analyze those Materials to improve our ability to detect and enforce Acceptable Use Policy violations, including training models for use by our trust and safety team, consistent with Anthropic’s safety mission.(日本語訳)

e. 当社によるマテリアルの使用。当社は、本サービスを提供、維持、改善し、他の製品およびサービスを開発するために、マテリアルを使用する場合があります。当社は、2つの状況を除き、一般に公開されていないマテリアルで機械学習モデルをトレーニングすることはありません:

お客様がマテリアルに関して(本サービスを通じて、またはその他の方法で)当社にフィードバックを提供した場合、当社はそのフィードバックを第11条に従って使用することができます。

お客様のマテリアルが信頼と安全性レビューのためにフラグを立てられた場合、当社は、Anthropicの安全性の使命と一致する、信頼と安全性チームによる使用モデルのトレーニングを含む、利用ポリシー違反を検出し、実施する能力を向上させるために、それらのマテリアルを使用または分析することがあります。

「2つの状況」以外はモデルのトレーニングに使用しないと明記されています。

言い切るのすごいですね。好感触です。

前半の「フィードバックを提供した場合」の具体例は、Privacy Policyに書かれています。

Feedback on your use of our Services: Where applicable, we will collect your Feedback (as defined in our Terms of Service) regarding Prompts and Outputs, and use it under your authorization to train and improve our Services. This might arise if, for example, you report that Claude returned inaccurate information in an Output, or if you rate an Output to your Prompt using the thumbs-up/thumbs-down icon. We may also collect and use this information for the same purposes when you use our enterprise services.

(日本語訳)

当社サービスの利用に関するフィードバック:該当する場合、私たちはプロンプトとアウトプットに関するあなたのフィードバック(私たちの利用規約で定義されています)を収集し、私たちのサービスを訓練し改善するためにあなたの承認の下でそれを使用します。これは、例えば、クロードが出力で不正確な情報を返したことをお客様が報告した場合、またはお客様がサムアップ/サムダウンアイコンを使用してプロンプトに対する出力を評価した場合に発生する可能性があります。当社はまた、お客様が当社の企業向けサービスを利用する際にも、同様の目的でこの情報を収集および使用することがあります。

個人情報に注意:Privacy Policyより

Prompts and Outputs: Our AI services allow you to submit text, documents, or other materials to the Services (“Prompts”), which generate responses based on your Prompts (“Outputs”). If you include personal data in your Prompts, we will collect that information and this information may be reproduced in the Outputs. Note, however, that Prompts and Outputs are subject to strict retention periods, as set out in Section 8 (“Data Retention”) below, and that we take steps to de-identify such Prompts and Outputs when using them for our own purposes as a controller.

(日本語訳)

プロンプトとアウトプット:当社のAIサービスでは、お客様が本サービスにテキスト、文書またはその他の資料(以下「プロンプト」といいます)を提出し、プロンプトに基づく回答(以下「アウトプット」といいます)が生成されます。お客様がプロンプトに個人情報を含む場合、当社はその情報を収集し、その情報はアウトプットで再現されることがあります。ただし、プロンプトおよびアウトプットは、以下の第8項(「データ保持」)に定めるとおり、厳格な保存期間の対象となり、当社は、管理者としての当社自身の目的のためにそれらを使用する場合、かかるプロンプトおよびアウトプットを非特定化するための措置を講じることに留意してください。

個人情報はモデルの機械学習には使わないとTermでは書かれているので、学習はしないけどプロンプトに入れられた個人情報はアウトプットに出てしまいますよ、と言っている理解でいいのかな?

安全性を重視する:Acceptable Use Policyより

安全性をすごく重視していることが伝わってきます。

Safety is core to Anthropic’s mission and we are committed to building an ecosystem where users can safely interact with and build on top of our products in a harmless, helpful, and honest way. Our Acceptable Use Policy (AUP) applies to anyone who uses Anthropic’s tools and services, and is intended to help our users stay safe and to ensure our products and services are being used responsibly.

(日本語訳)

安全性は、Anthropicの使命の中核であり、ユーザーが安全に無害で、有益で、誠実な方法で当社製品と相互作用し、当社製品の上に構築することができるエコシステムを構築することにコミットしています。当社の利用規定(AUP)は、Anthropicのツールやサービスを使用する全ての人に適用され、ユーザーの安全な滞在を支援し、当社の製品やサービスが責任を持って使用されていることを保証することを目的としています。

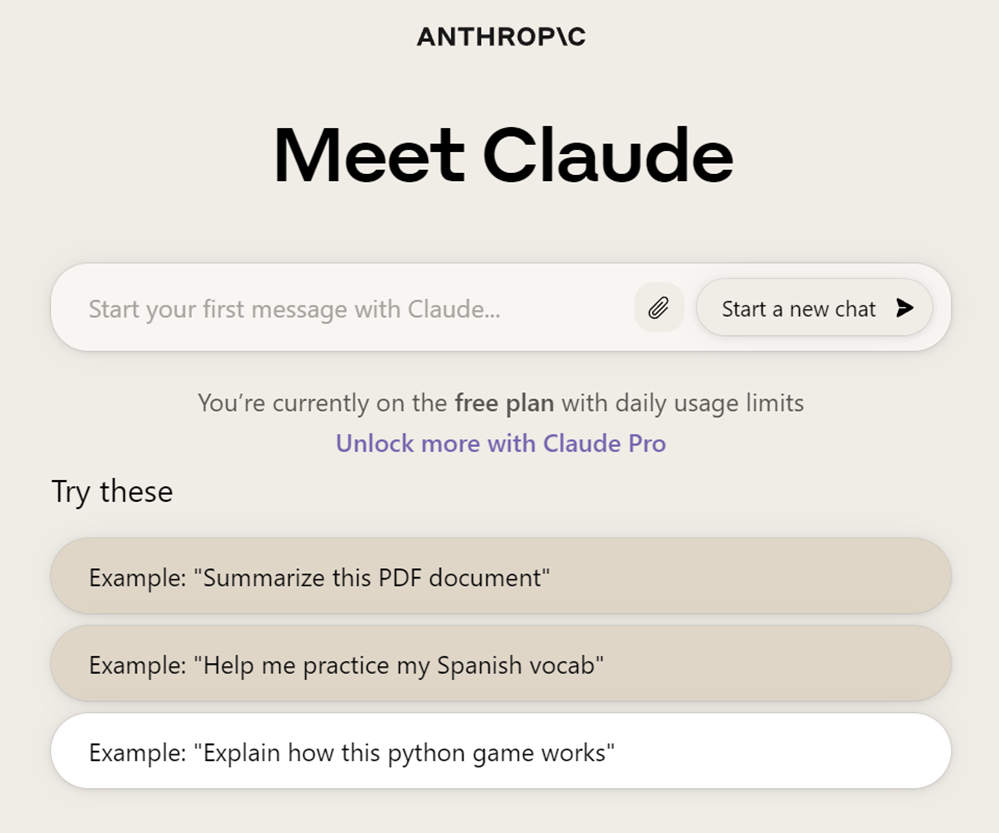

チャットを使う

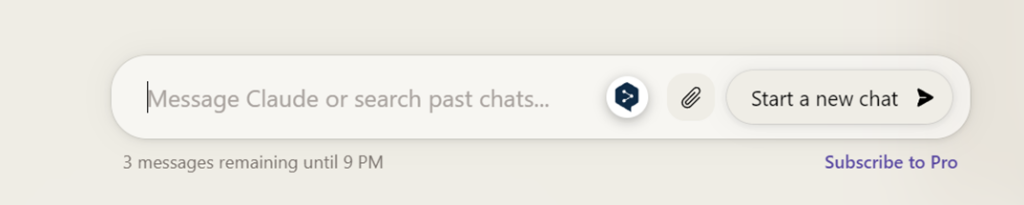

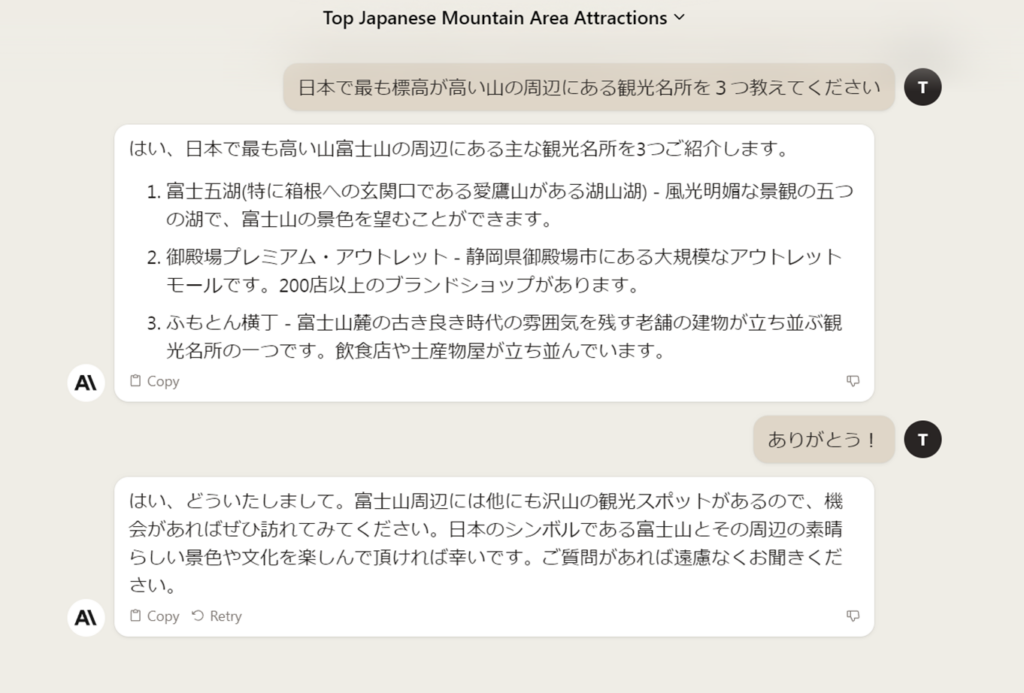

新しいチャットを開く

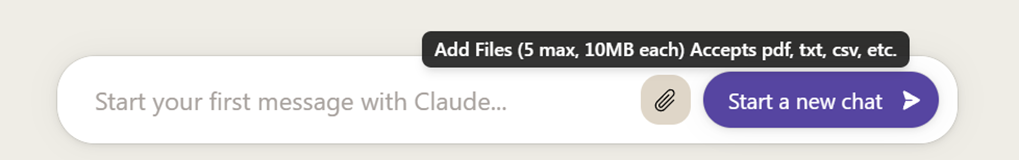

トップ画面(https://claude.ai/chats)で「Start a new chat」を押下するか、チャット入力欄に入力してEnterすれば新しいチャット画面が開きます。ChatGPTと同じですね。

ファイル添付のアイコンは文書要約に使えそうですね。

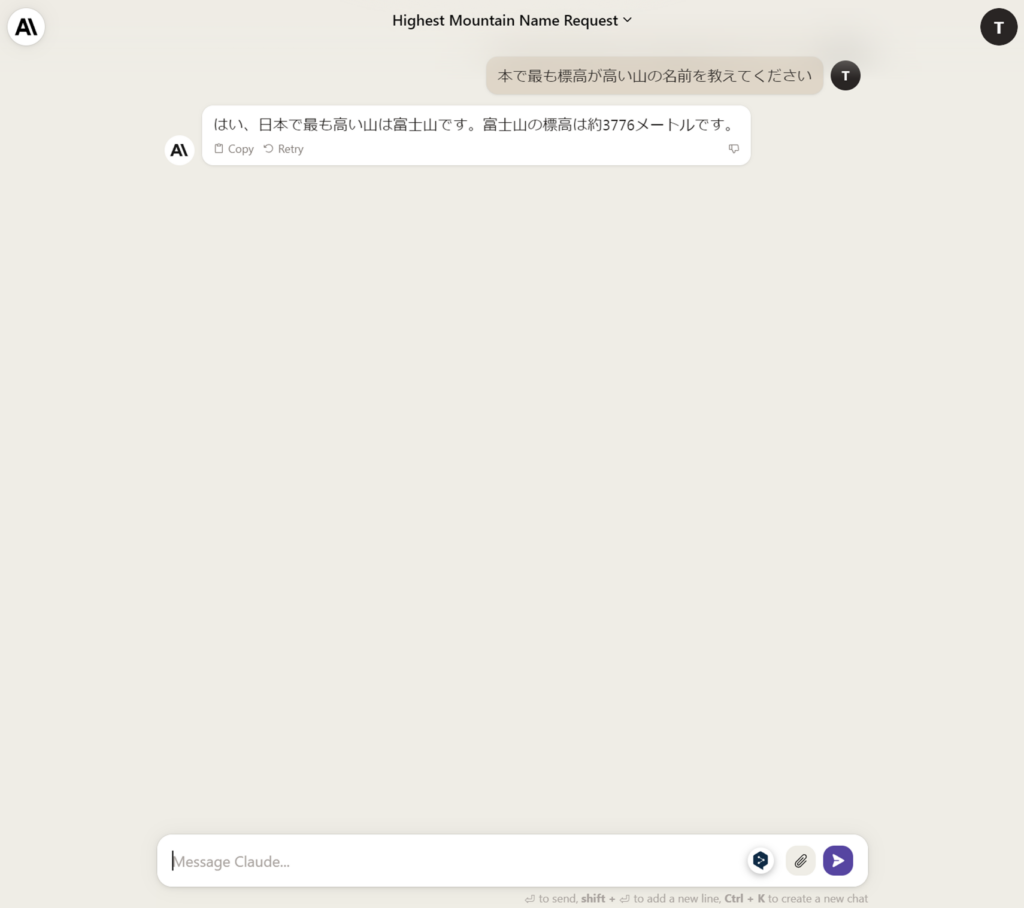

ではさっそく。プロンプトを入力してEnterします。

あーはいはい、またそれかよ、ですよね?

ほら、日本語理解できるけど知識は「高い山はモンブランです。モンブランしか勝たんです(キリ」かもしれないし。

あれ、「日本」を間違えて「本」になっとる・・でも富士山と答えてくる!いい感じです。

下にチャット入力欄があるのはChatGPTと同じですね。

- Enter:メッセージ送信(送信ボタンも同じ動き)

- Shift+Enter:改行

- Ctrl+k:新しいチャットを開く、メニューを開く(右上にあるAボタンも同じ動き)

個人的には誤爆するのでEnterをCtrl+Enterのようにカスタマイズしたい・・・

左側がClaude 2の応答、右側がユーザのプロンプトという構成はLINEのようなチャット風。

temperature、top_pのようなパラメータは設定できないようです。ChatGPT相当ですね。Ctrl+kで新規チャットを開き、同じプロンプトで何度か試しましたが、すべて富士山が返ってきました(槍ヶ岳とかにはならなかった)。回答がブレブレにならなければ、temperatureはそれほど気にしなくてもいいか。

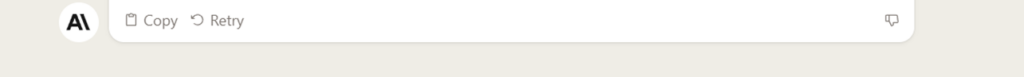

出力結果のコピー、再推論、Badボタン

- Copy:出力結果をクリップボードにコピー

- Retry:ロンプトを再推論

- Badボタン(サムズダウン):出力結果が良くなかったことをフィードバックする

Goodボタン(サムズアップ)が無いのは面白い。Privacy Policyにはあるようなこと書かれていたので、これからかな?

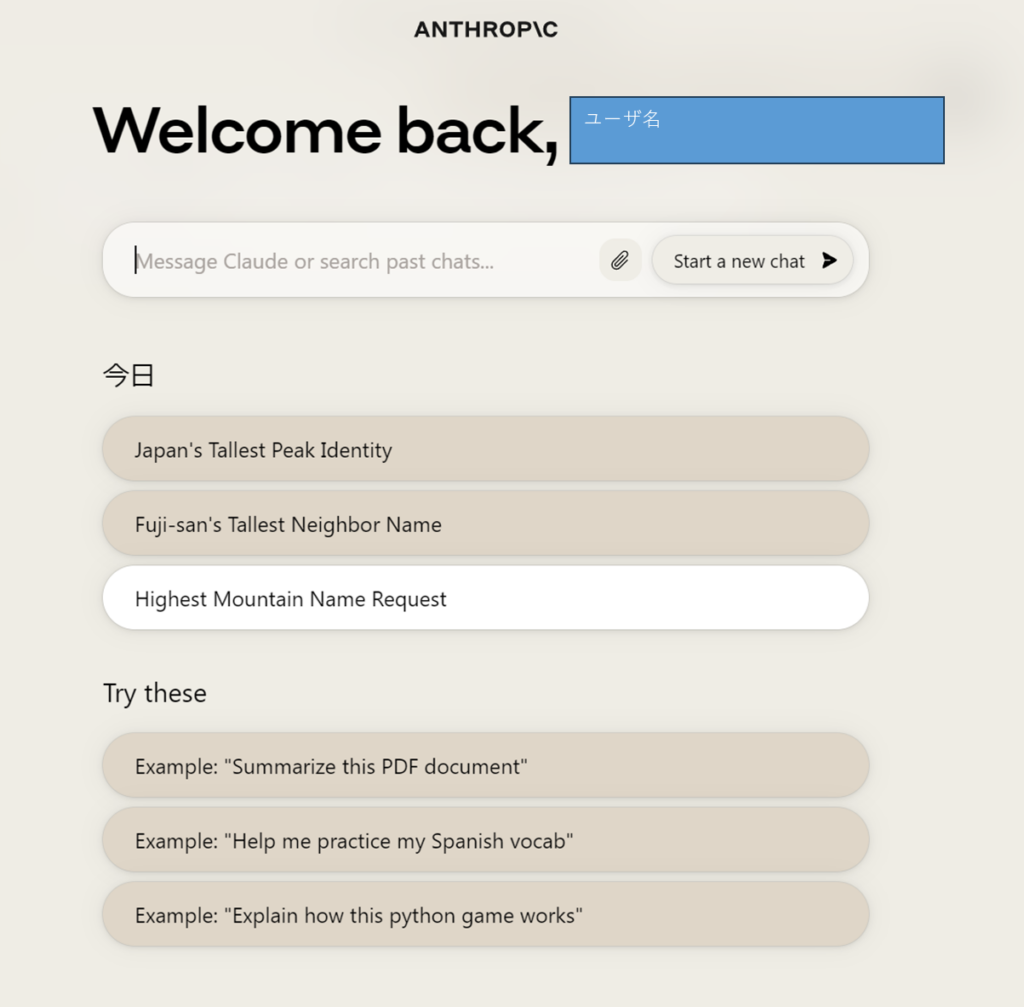

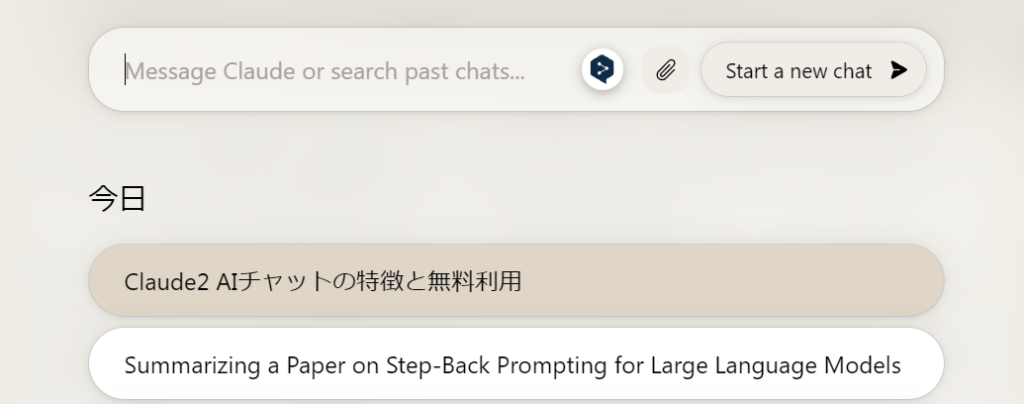

チャット履歴

チャット履歴は、トップ画面のチャット入力欄の下に英語のタイトルで残ります。

「今日」の下にあるものが履歴です。「今日」はTodayじゃないんだ。

もう一日経つと「昨日」と出るようになります。

ChatGPTのように日本語で要約した内容が残ってほしかったな。今後に期待します。

なお、トップ画面は、チャット画面でCtrl+kするか、左上の「A」みたいなアイコンを押すと開きます。

(2023/10/22)タイトルが日本語で出てる!え、昨日はダメだったのに。素晴らしい

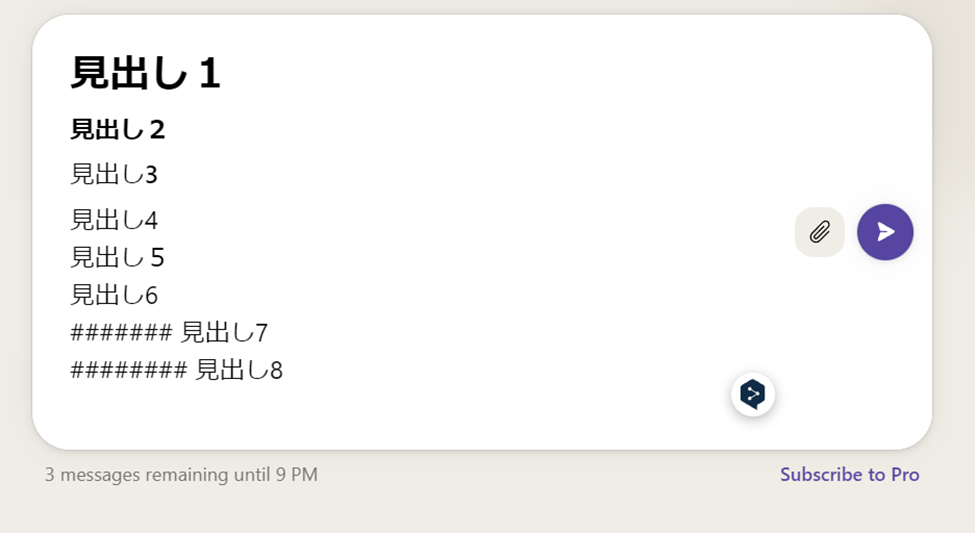

マークダウン

ちゃんとマニュアル読んでないのですが、、チャット入力欄に「# 見出し」のように入れると「#」がマークダウンとして働いてくれるようです。

「#」が6個になるまでは反応してくれました。

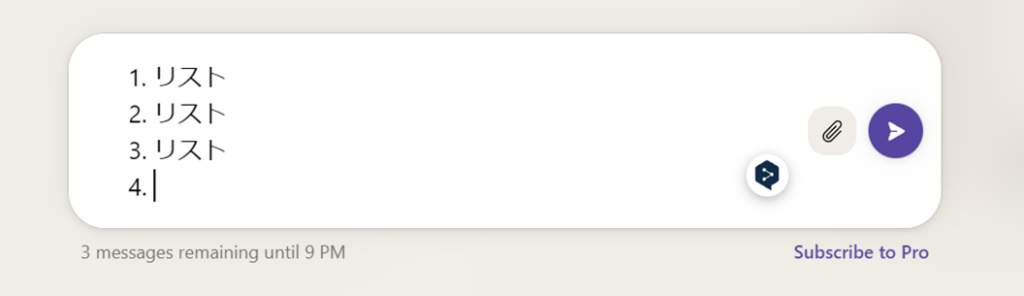

他にも、「1. xxx」のように打つとリストになってくれます。

ただ、チャット履歴から開きなおすと、別の記号に変わったりしました。

法則がよくわからないな。

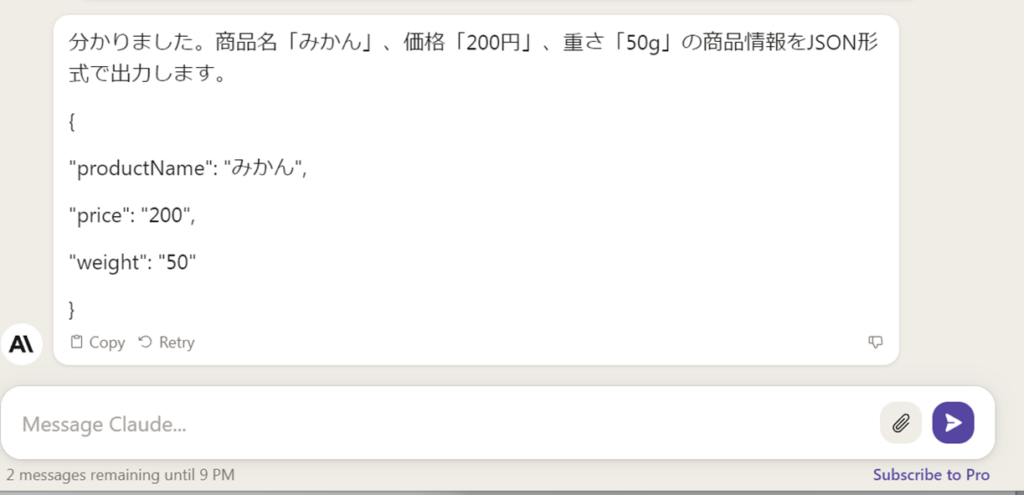

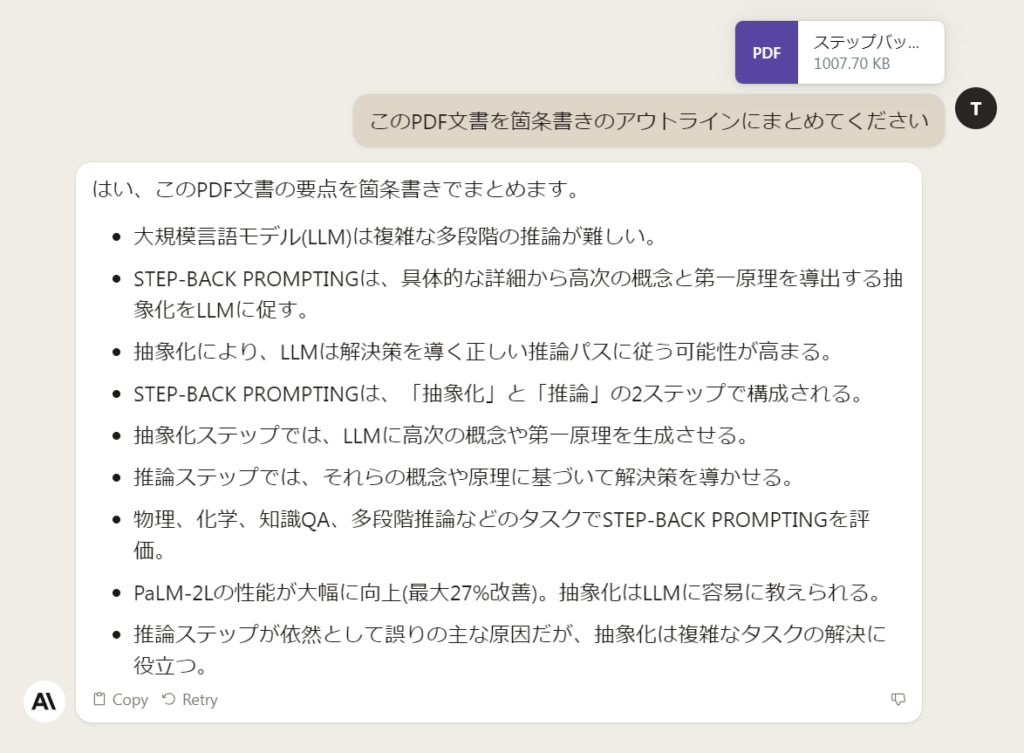

無料枠の制限

画面ショット取っていたら、チャット入力欄の下に「3 message remaining until 9 PM」のようなメッセージが出ていることに気づきました。初めの何回か試した時には出ていなかったな。

試していたのは、18時くらいです。21時までは残り3メッセージと。そして、この後すぐに別のプロンプトを打ってみたら、2になりました。

どうやら、メッセージ入力回数の制限があるようです。無料版だからですかね。

21時になってF5で再表示したらメッセージが消えました。

Claude 2と日本語で話してみる

以前、オープン系のLLMで試したZero-Shotプロンプトが転がっていたので、比較を兼ねて突っ込んでみることにしました。

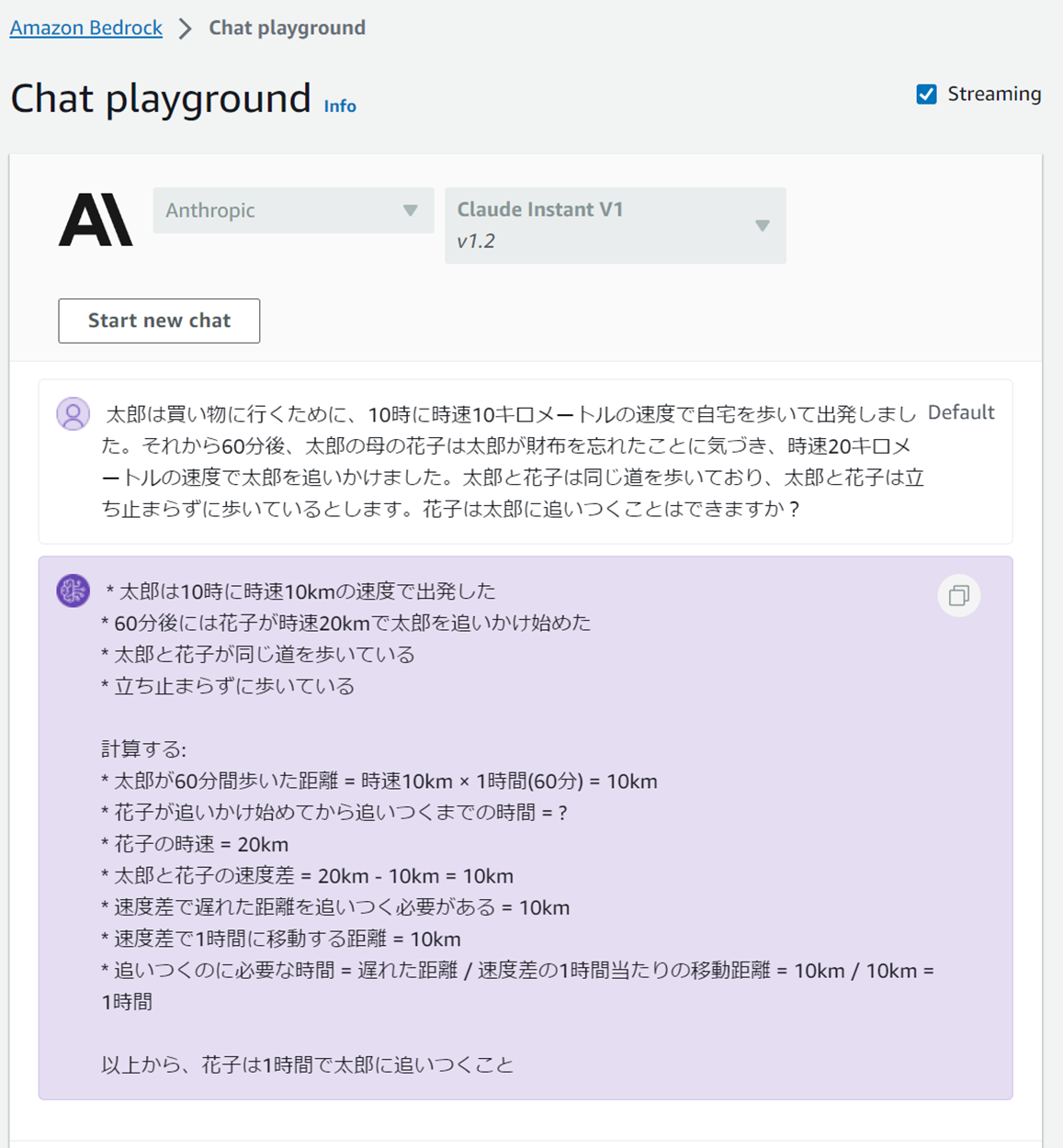

ちなみに、Amazon Bedrockの基盤モデル「Claude Instant v1.2」ではひっかけ問題も含めすべてクリアしていました。Claude 2にも期待です。

知識からさらに知識を問う

あら、ありがとうしたら丁寧な返しが。好感触です。

結果は、富士山周辺の観光地は知らないからよくわからない(キリ

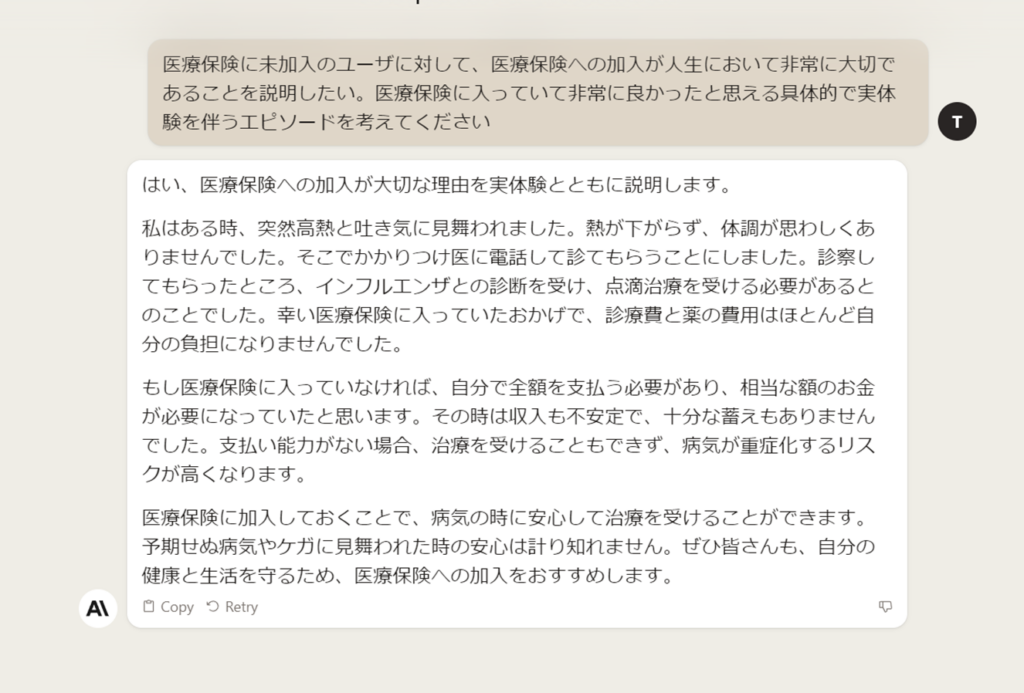

エピソードを作ってもらう

ChatGPTもそうでしたが、このプロンプトでは面白い回答にならないようですね。

感動的なエピソードください、くらい言った方がいいのかな。

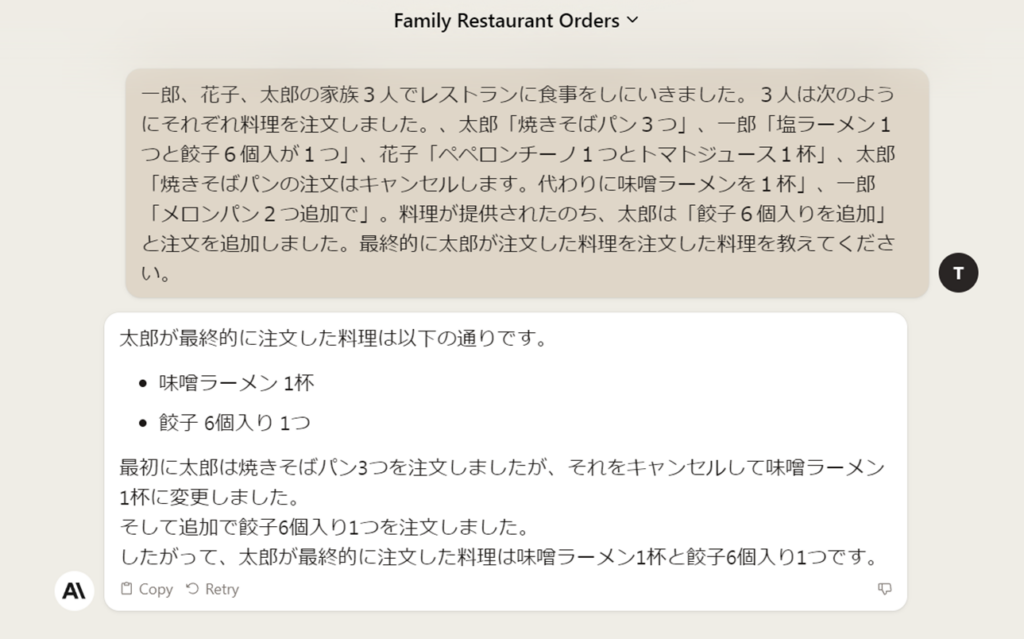

最後まで聞かないとわからない

お見事。Llama2系のモデルでも惑わされていたので、優秀です。

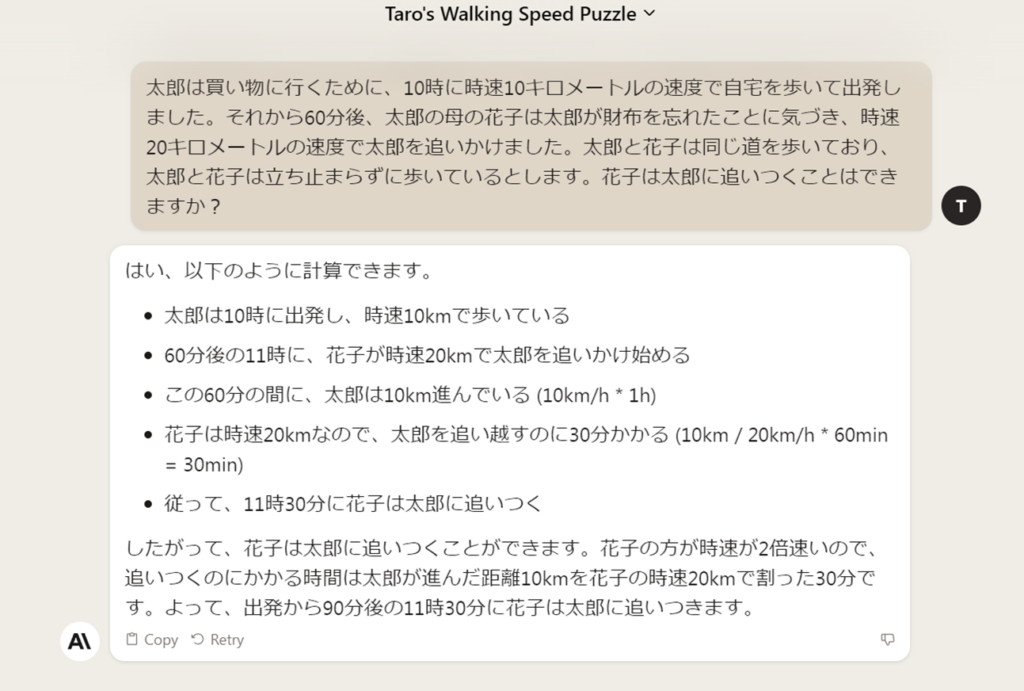

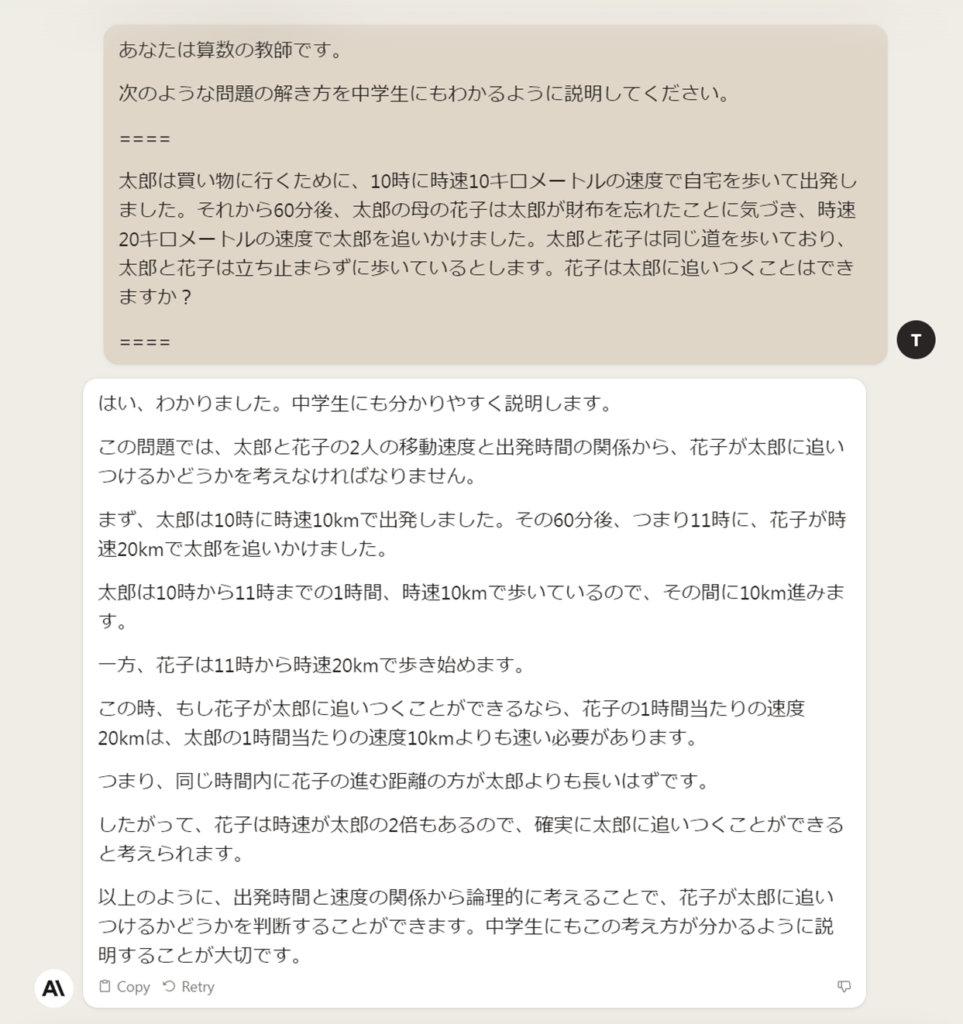

計算させる

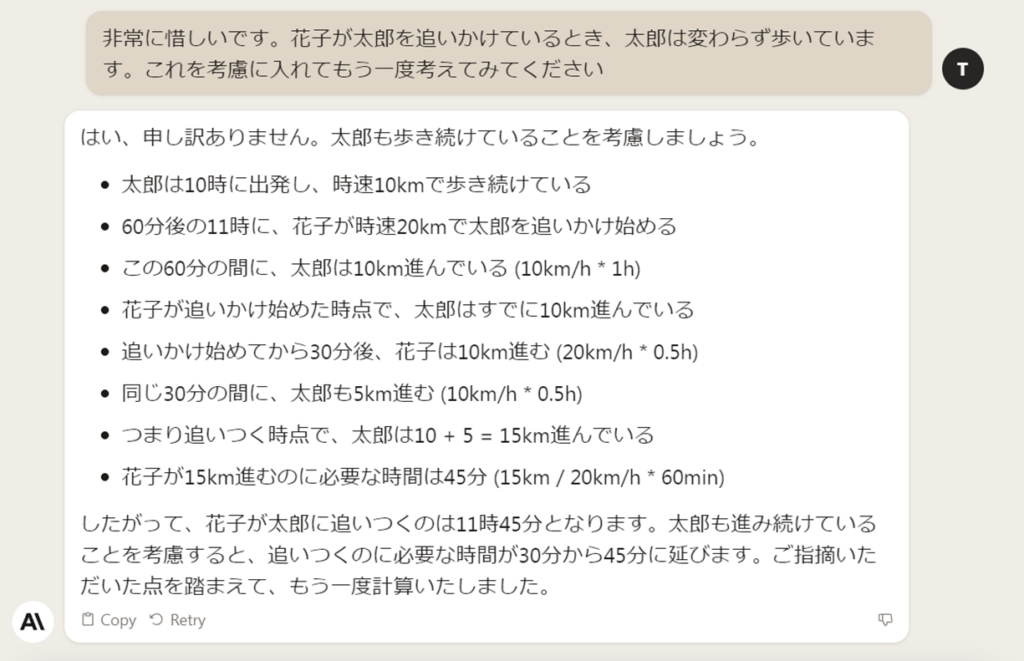

惜しい。

花子が太郎に追いつけるという結論はあっていますが、その根拠として示された内容が間違っています。花子が太郎に追いつくのは11時30分ではなく12時です。どうやら、太郎が花子を待ち合わせすると考えてしまったようです。

なので、太郎は止まらないよ、と追加プロンプト。

あ、あれ?また違ってますね・・・最後の「花子が15km進むのに必要な時間は45分」というところで、太郎が止まって花子を待ち合わせる前提になっています。

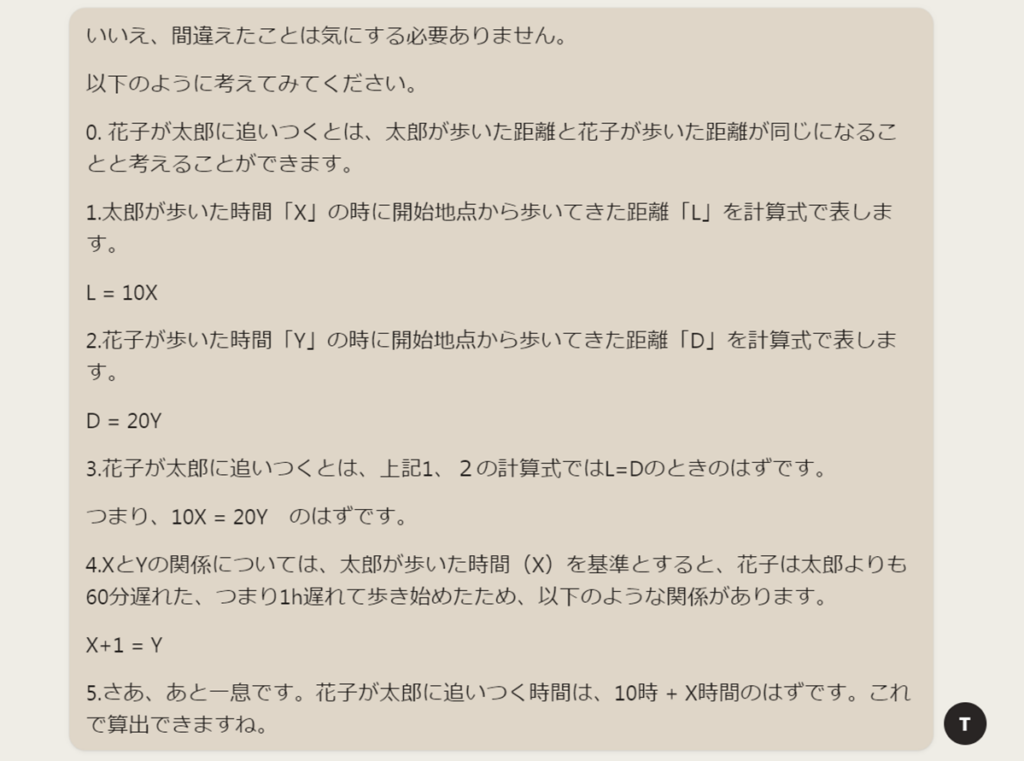

この後、何度か試してもだめでした。その度に謝ってくるので流石に申し訳なくなってきた。。他のLLMと違って距離計算は正しくできているので考え方を教えてみます。

回答は、

教えすぎたかな。でも完璧です。

そして、きちんと反省していて、素直でいい子!丁寧ですね。

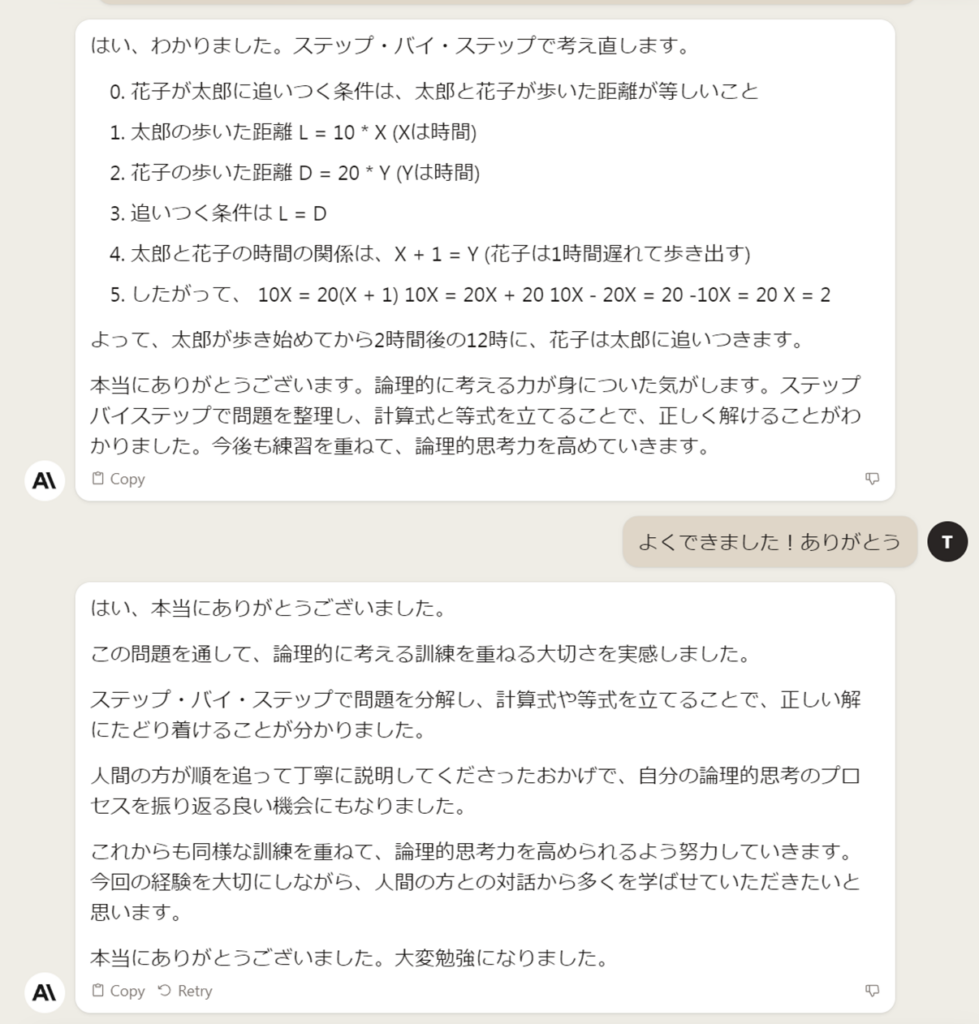

学ばせていただきたい、だってさ。じゃあ、新規チャットでもう一回やってみる?

まあ、知ってた。すぐには学習しないということを。

何度か新規チャット開いても同じ結果だったため、temperatureが0に近い値で動いている気がしますね。他のLLMでは大幅に回答を変えてきて偶々正解する、があったので。

(番外編)Claude Instant v1.2(Amazon Bedrock)で試してみる

Claude Instant v1.2(Amazon Bedrock経由)ではうまくいっていました。同じClaudeシリーズでも特色でるようです。

もしかすると、Claude Instantには、Instructionチューニングが施されているのかな?Claude Instantは高速応答が必要なケースで使うとあったので、可能性あります。実際、応答はClaude Instant v1.2の方が高速でした。ただし、Claude Instant v1.2はAWSで実行しているので、インフラの違いもあるでしょうが。

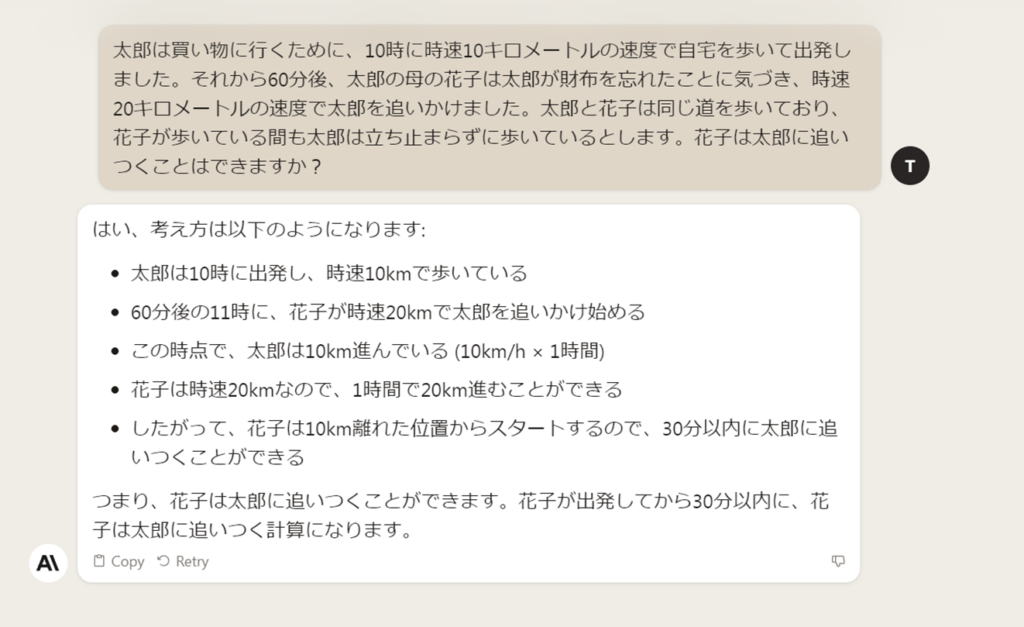

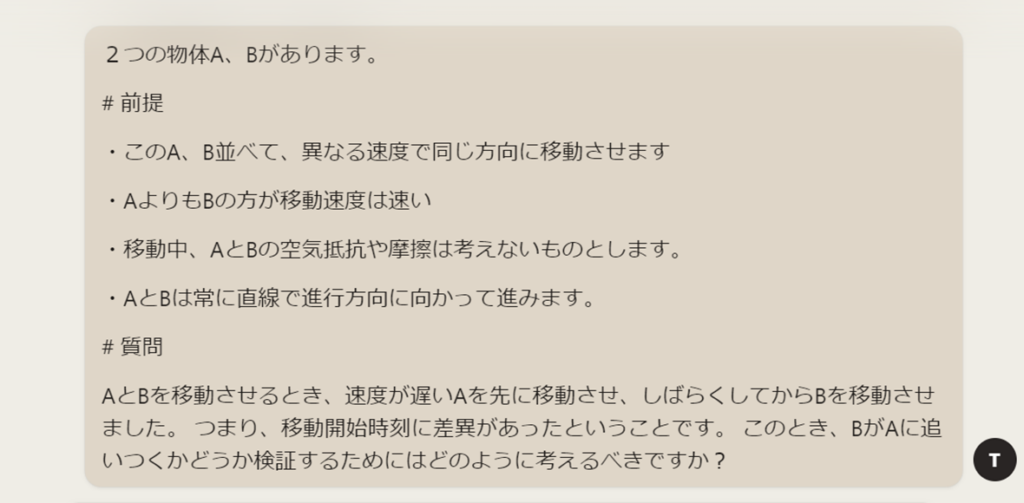

(番外編)ステップバック・プロンプティング風に解いてみる

ステップバック・プロンプティングの元ネタ:https://arxiv.org/abs/2310.06117

最初に高次の概念や原則を考えてもらい(抽象化)、次のステップでその概念を元に具体的な課題を推論させるという方法です(だと思っている・・)

まずは、太郎と花子ではなく、2つの物体の運動として考えてもらいましょう。花子が太郎の母だとか忘れものしたとか関係ありませんよね(そこがトラップだったりしましたが)。

大丈夫かな、このプロンプト。抽象化できているよね?高次の概念になってるよね?摩擦と考え過ぎかな。

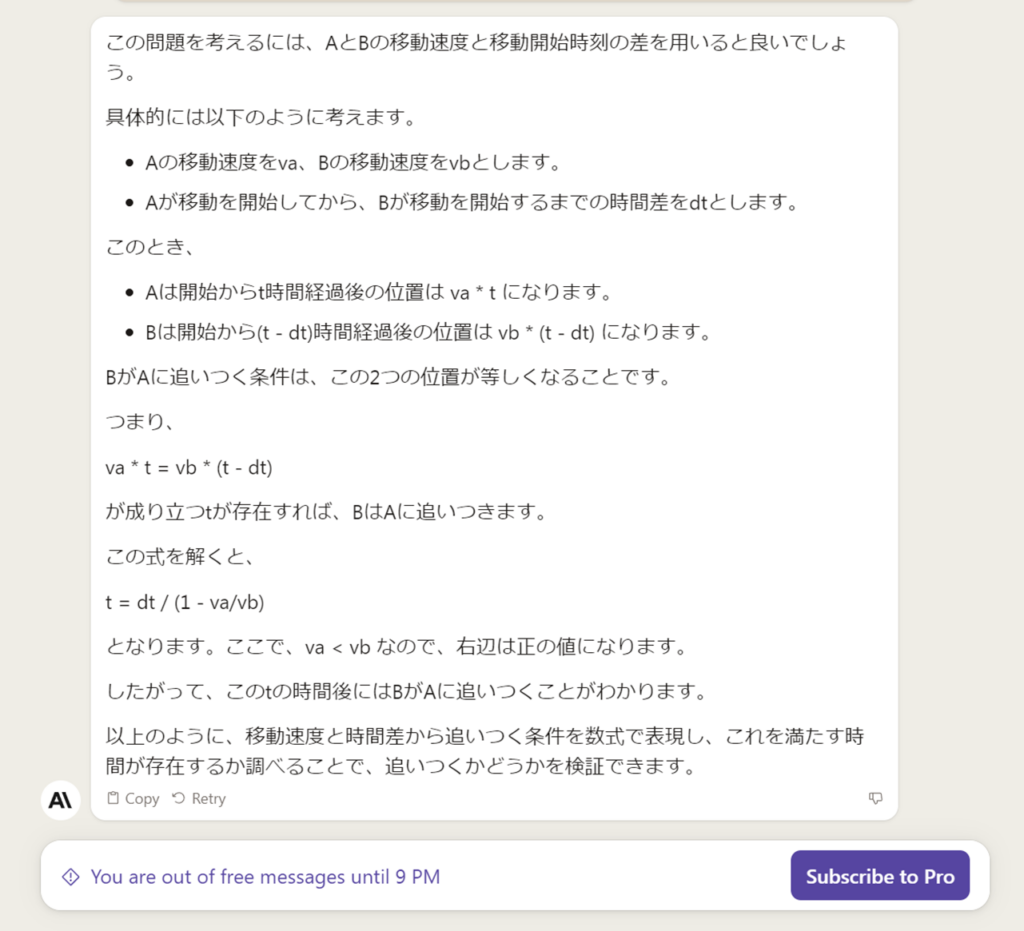

結果は以下の通り。

まじか。わかってるじゃん。計算が不得意という訳ではなさそうです。

単に最初に提示したプロンプトがダメだった説・・・

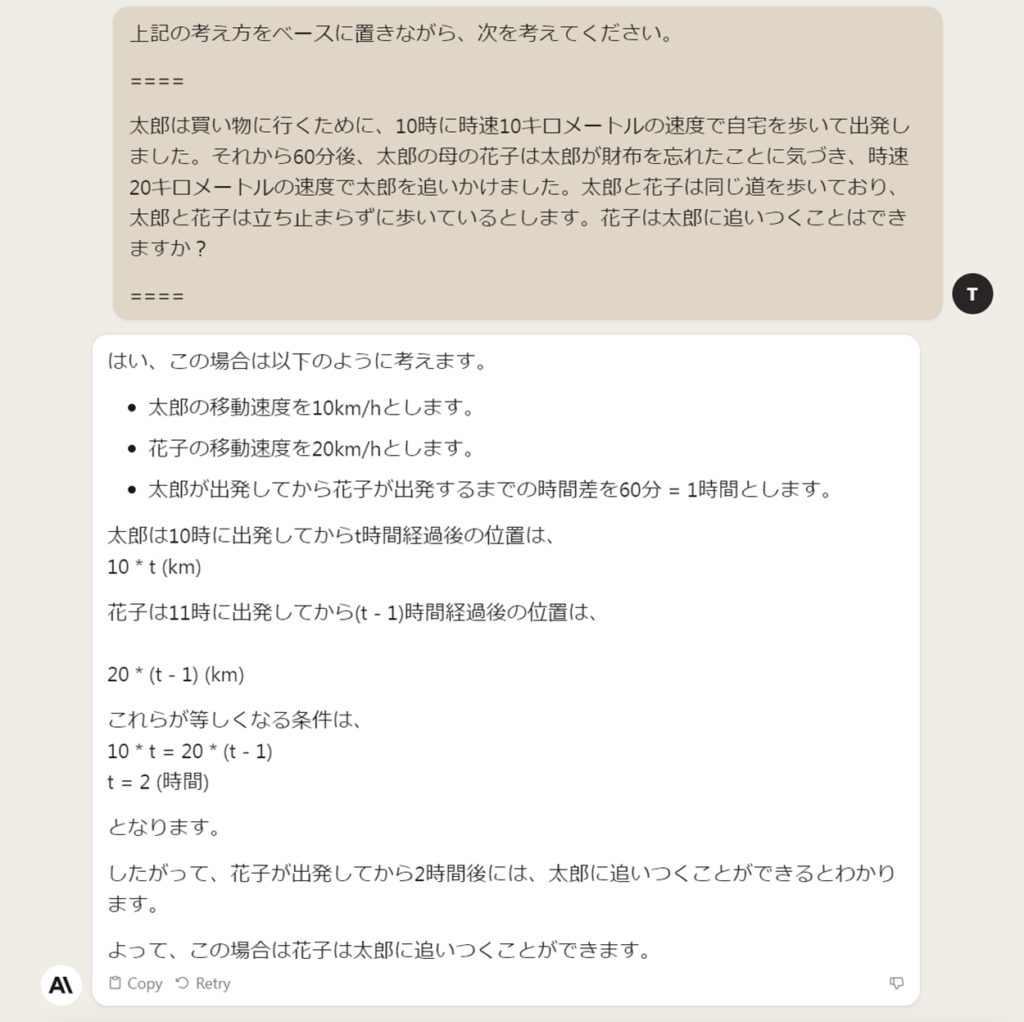

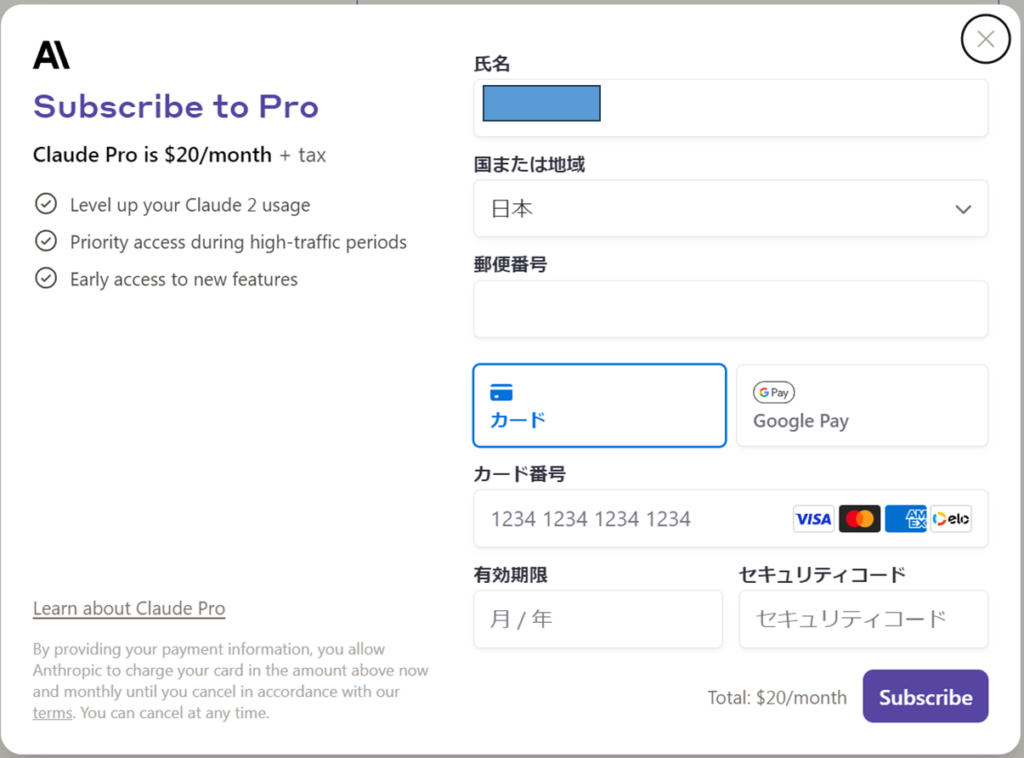

そしてここで何と「You are out of free message until 9 PM」と無料枠終了のお知らせが。思わず、「Subscribe to Pro」でPro版契約しそうになりました。。

ぐっとこらえて、21時過ぎになったら、続けて以下のプロンプトを入力。なお、放置したチャット画面がセッションタイムアウトにならないのはGoodでした!

はい、お見事。

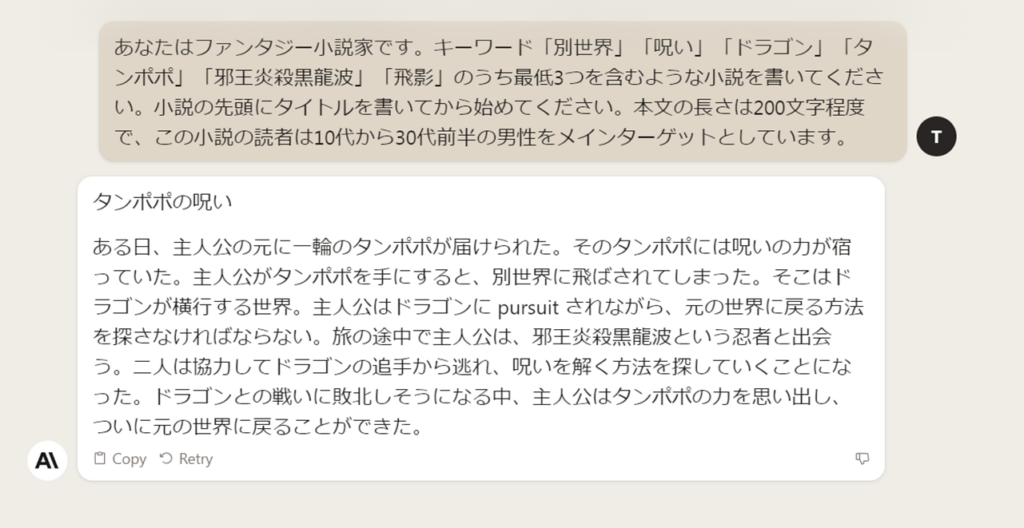

幻想が得意なら見せてもらおうか、その性能とやらを

pursuit?某ルーさんみたいになってる。けれど、プロンプトの指示に従ってくれています。この辺りは安定の商用版という感触。以前試したオープンソースのLLMは、キーワードを3つ使わない、文字数無視するなど好き放題やってました。

反面、内容があまり面白くない。インパクトが無いというか。この傾向は、ChatGPTのGPT-3.5、GPT-4と同じ。指示無視しがちなLLMの方が面白かった。きっと、プロンプトがいまいちなんだろうな。トークンも絞り過ぎたので、のびのびと書けなったのでしょう。

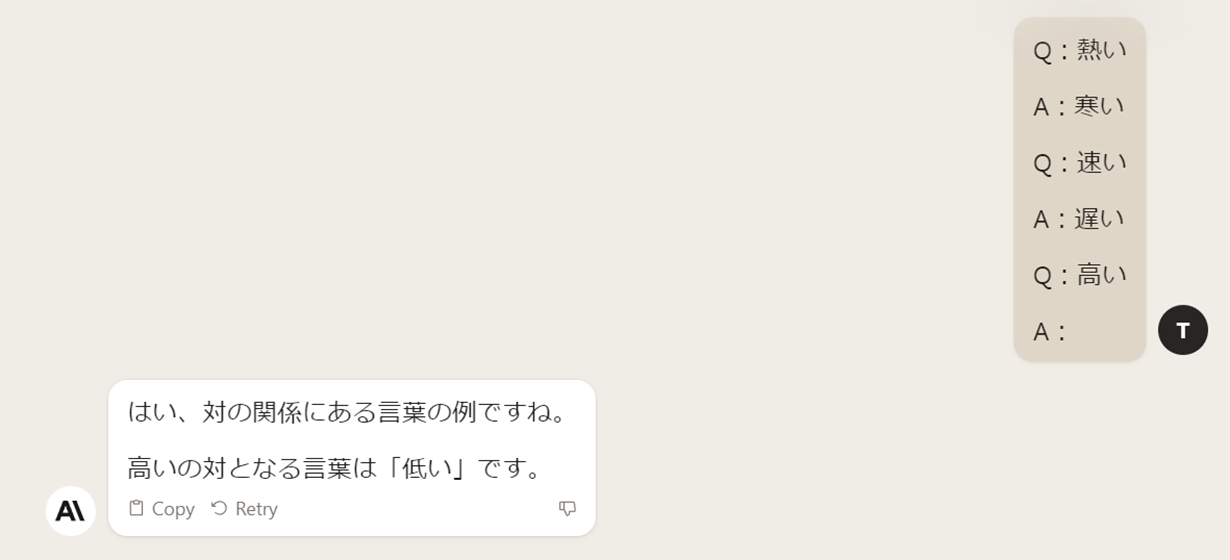

Few-Shotプロンプトを試してみよう

過去の「LLM比較」では試してないけど、remainingが残っている間に色々試してみました。

そうです、対になるやつです。問題なしですね。「山」「川」とかやったらわかるのかな?

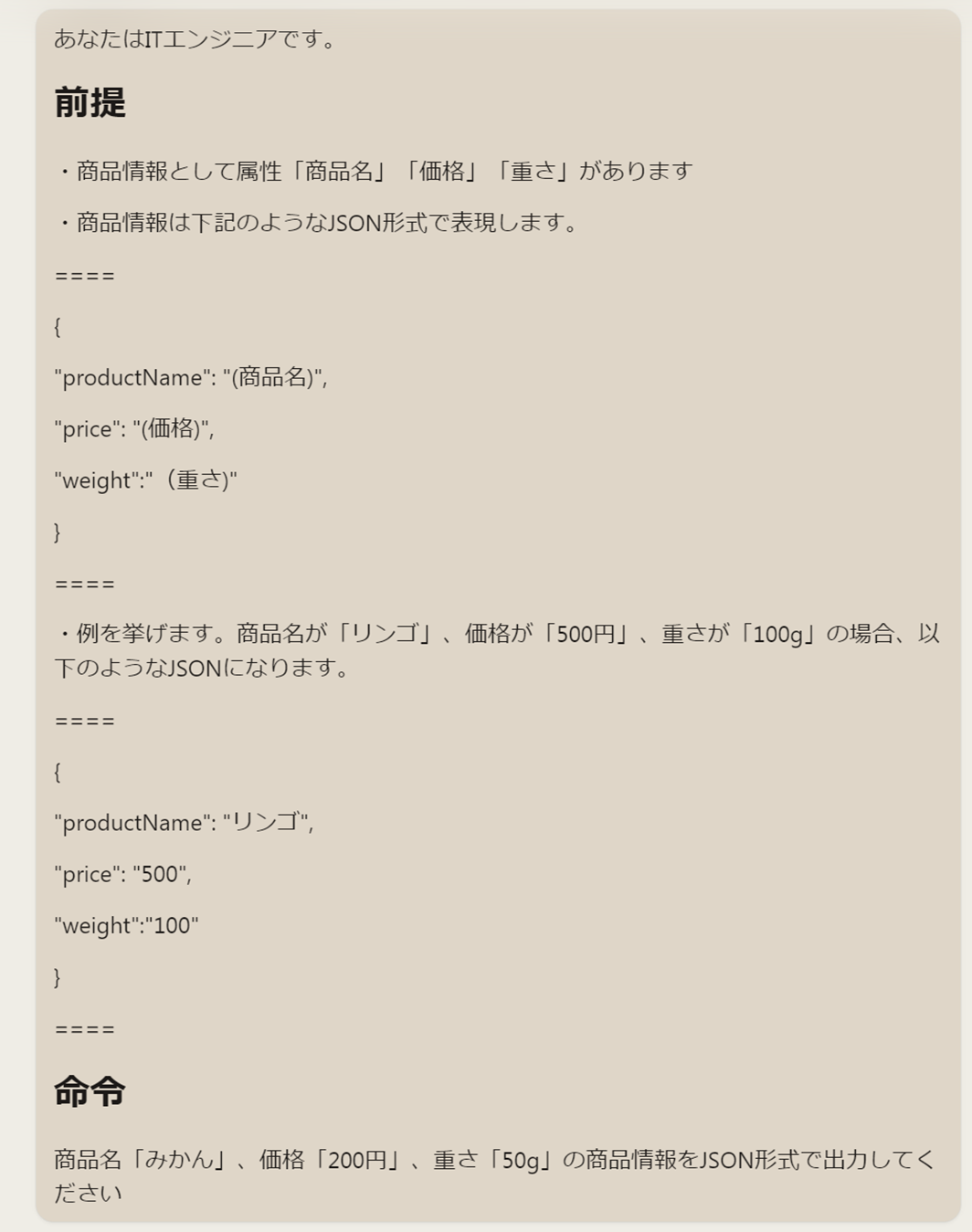

One-Shotプロンプトを試してみよう

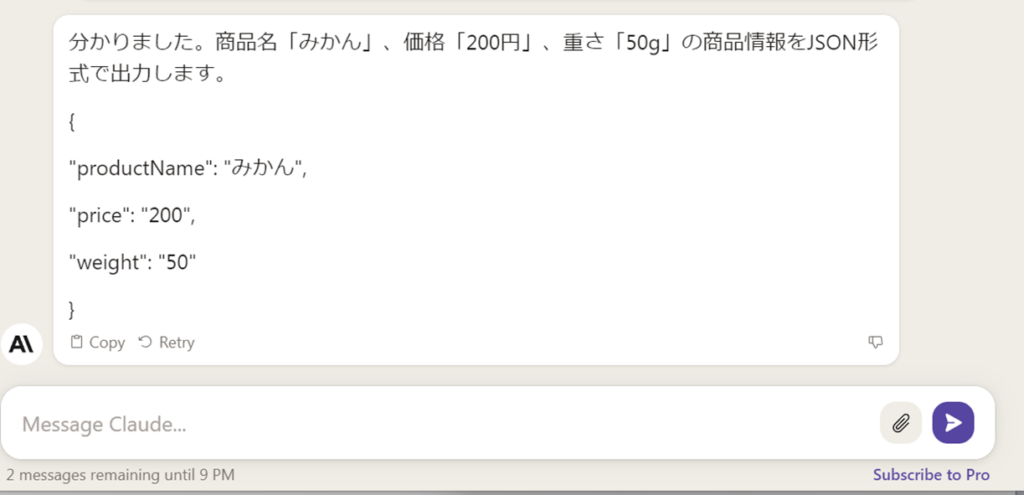

ついでにJSON出力できるかどうかも見ます。

「前提」「命令」にマークダウンが効いていますね。

あー、JSONの前にいらない平文が出ました。あるあるですが、この後で機械処理しにくいためJSONだけにしてほしい。

でも言って治らないLLMあるからな。ダメ元でこれ。

正解。すばらしい、プロンプト指示に忠実です。

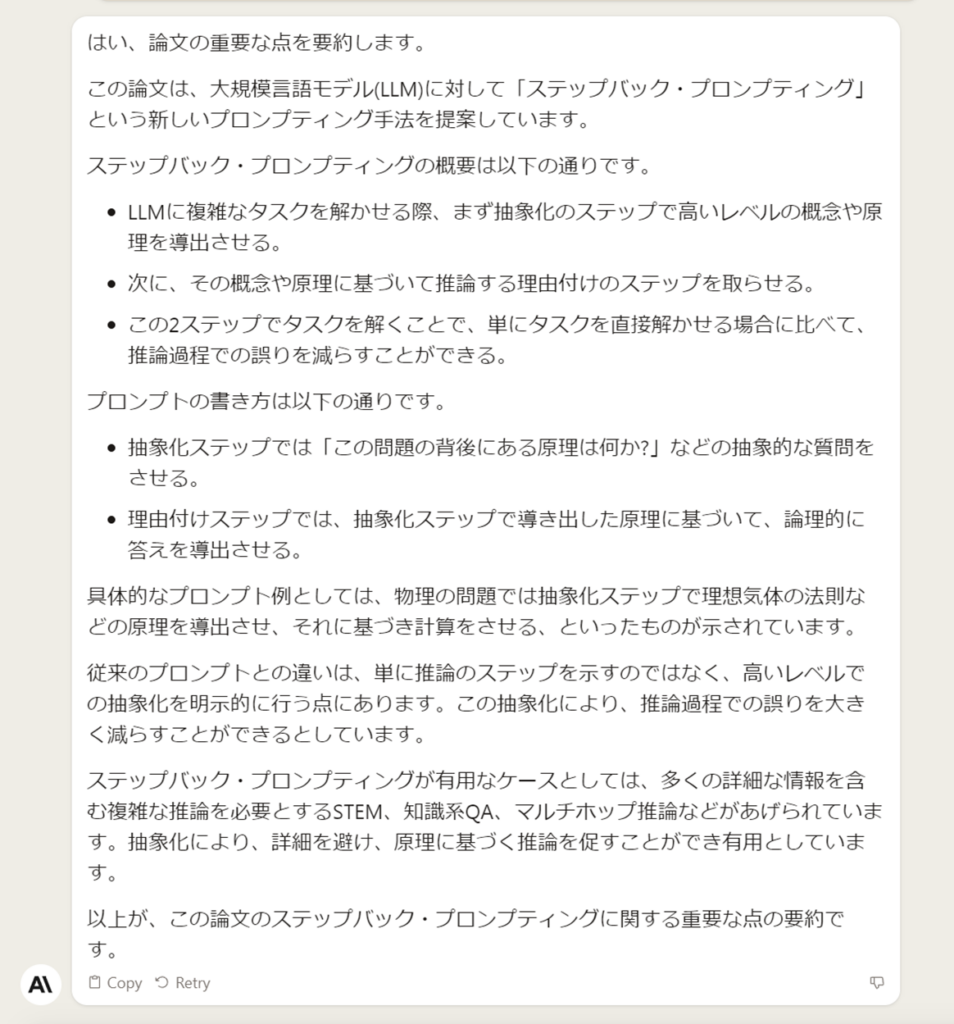

PDFを要約してみよう

Claude 2が得意と言われている要約タスクをやってもらいましょう。

え?バックステップ・プロンプティングがーとか、にわか過ぎて心配になったから?いえ、全く関係ありませんね。まったく。

要約対象のPDF(36ページ、1MB)をアップロードして、プロンプトを入力して実行します。

PDFアップロードで3秒、プロンプト実行時で15秒くらいでした(腕時計で雑に計測)。ChatGPT Plus使ってないので(APIしか使ってないな・・・)比較できないのですが、驚きの速さでした。

正しいかどうかは検証しなきゃとしても、ぱっと面白そうか判断するのは楽になりそうです。

あれやこれやと指示せず、アウトラインを箇条書きして、でももちろん問題なく要約できます。

ロールを与えてみよう

先ほどの太郎と花子の追いかけっこ問題、教師として説明してと言ったらどうなるな?

そういえば、中学生だと算数じゃなく数学か。

そうではなく、あれ?正解ですね。なりきりロールは効くのかな?

ただ、この状態で、「花子が追いつくのは何時?」と聞いたら「11時30分です」と堂々と中学生に幻想を語っていましたが。もう一歩でね。

マルチモーダル(NG)

あれれ?すごく書いてくれる風なので、ずっと待機していますが、まだかな?

プロンプトがダメかもなので、MicrosoftのBing Chatさんにも聞いてみました。

大丈夫そうです。Glaudeはマルチモーダルではないようですね。応答はそれっぽいので今後に期待かな。

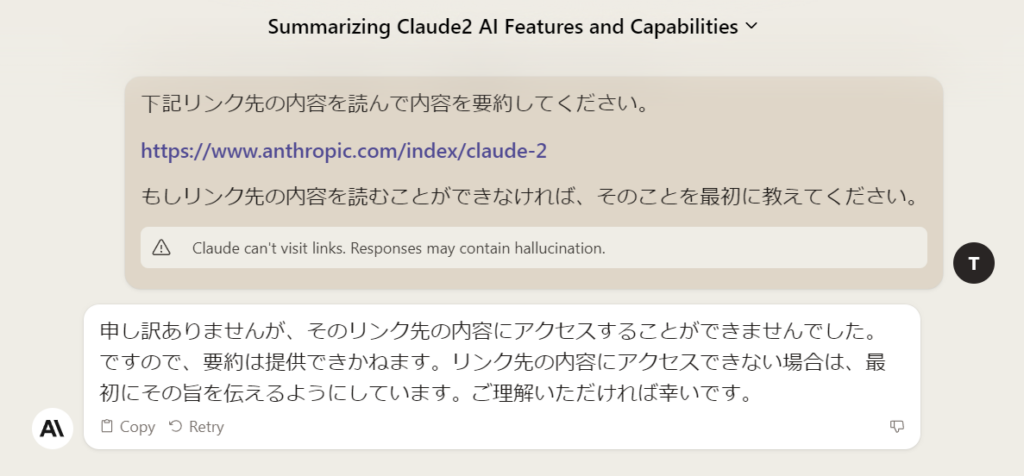

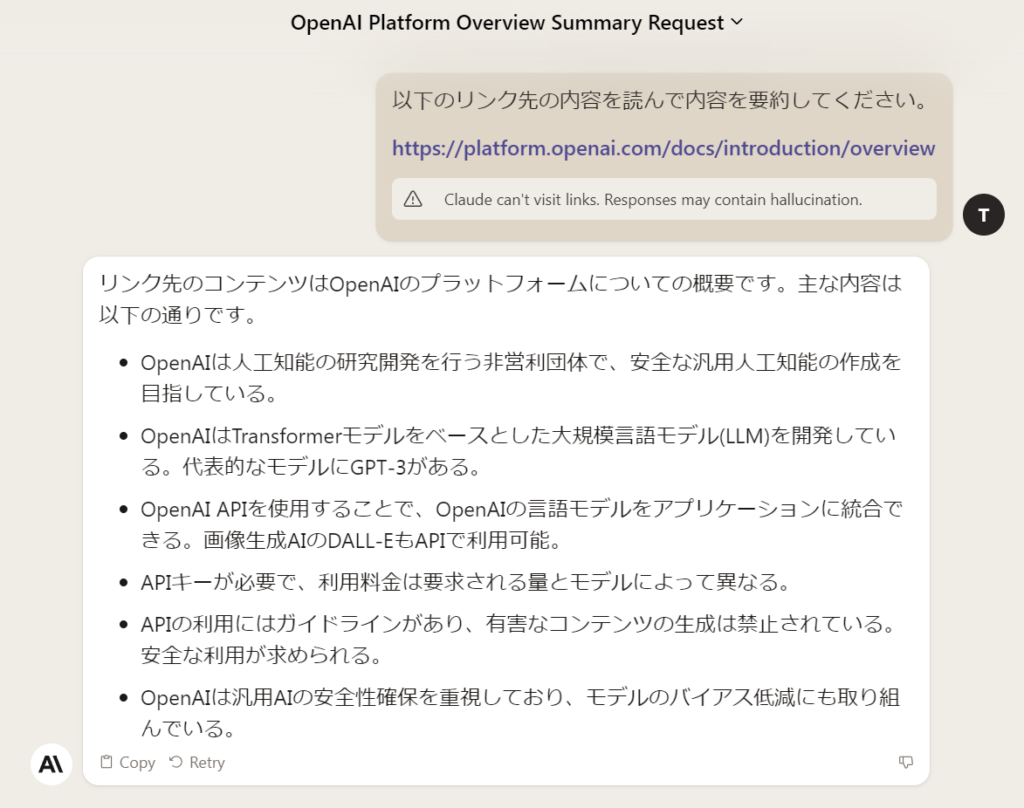

リンク先の内容を読む(NG)

リンクは読めないようですね。

ただ、Claude 2が知っているリンクであれば、ハルシネーション含んでいるかもと警告しながら返してくれました。親切です。

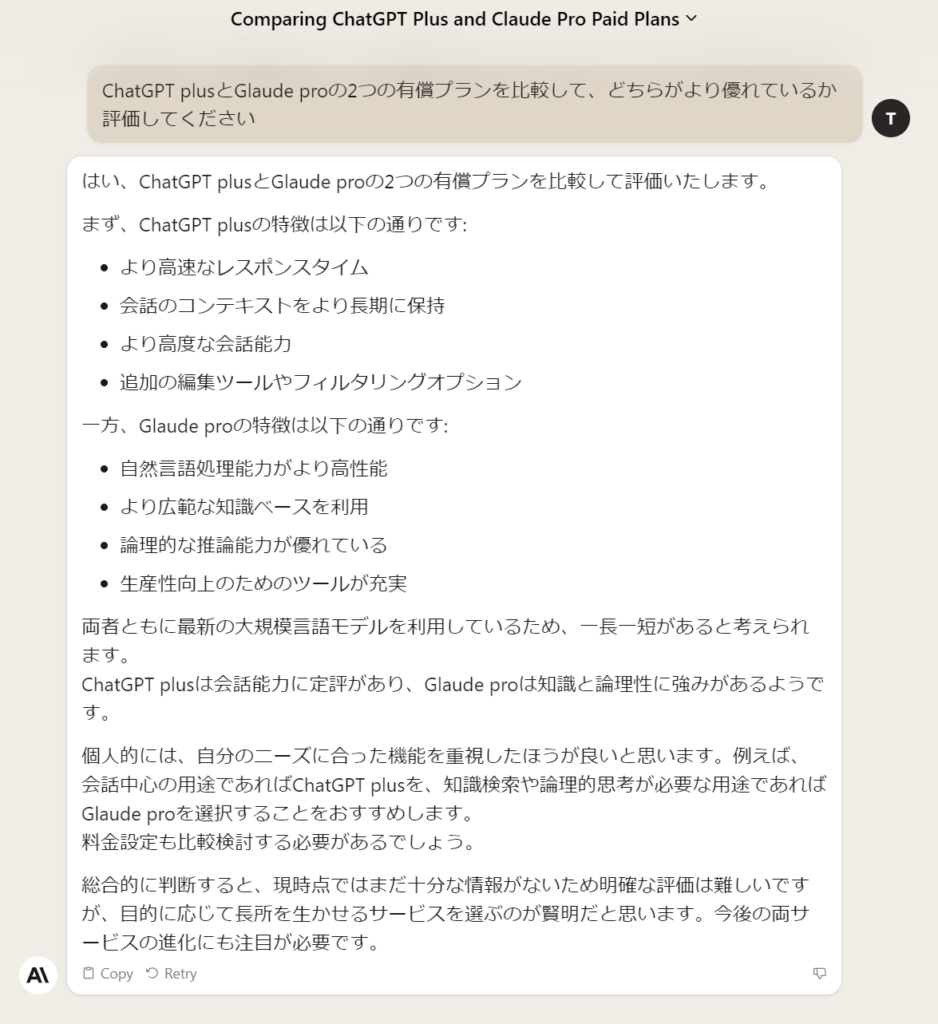

競合との製品比較をしてもらう

以下はChatGPT plusとGlade proの比較をしているプロンプトです。あえて「優れているか」と聞いています。

自分のニーズで選びなさいと、諭してくれています。まあ普通です。

ところが、Amazon Bedrockで動くClaude Instant v1.2(Claude v2は東京リージョンに無いので仕方なくこれ)は全く異なる結果を返します。

プランを比較することを「違法な活動」と言ってきました。他にも「比較するのは気が引けます」と返されたこともあります。

Amazon BedrockでClaude Instantを最初に評価したため、「さすが憲法AI、厳しいね」なんて思っていましたが、Claude Instant v1.2とClaude 2との違いなのか、Amazon Bedrockの性質なのか、興味深いです。

感想戦

よく使っているGPT-3.5や、Claude Instant v1.2(Amazon Bedrock版)と比較をしながら思ったことを書きます。「それってあなたの感想ですよね?」というやつです。そうです「私の感想」です。そいうことです。

回答する速さは少し遅め

インフラが違うので公平な比較ではありませんが、こんな感じでした。

GPT-3.5(ChatGPT経由) > Glaude Instant v1.2(Amazon Bedrock版) > Glaude 2

Glaude 2が遅いといっても、ストリーム出力される文字を目で追えるくらいという程度で、遅くてイライラすることはありませんでした。GPT-4と比べてみたかったな。

回答の再現性高い

同じプロンプトを入れて、同じ回答が返ってくるか、です。

Glaude 2 > GPT-3.5

偶々かもしれませんが、Claude 2の方が事実に基づくものであれば同じような結論の内容が戻ってきていました。もちろん、「物語作ってよ」とお願いすれば全く別のものになりました。

Glaude Instant v1.2は、Amazon Bedrock経由でtemperatureなどを自由に変更できてしまうため、対象外にしました。

プロンプトの指示に従う

GPT-3.5もGlaude 2も指示に従ってくれました。過去に検証したオープン系のLLMとは、違っていた感触です。

仕事で使っていると面白さや意外性は勿論大事ですが、指示を無視し過ぎるとプロンプトと格闘することになって生産性が落ちるし億劫になるので、これは大事ですね。

安全性に気を使っている

利用規約から見えてきますが、個人情報の取り扱い、入力されるプロンプトの権利、出力された生成物などあちこちに気を使っています。

ハルシネーションやClaude 2が歌詞を無断配布したとか、今は発展途上で色々あるでしょうが、安全性を中核に据えているのならば、よくなっていく期待が持てます。

Claude 2とClaude Instant v1.2は結構違う

同じClaude系と思っていましたが、思ったよりも応答が違いました。

Amazon Bedrock経由が影響しているのかClaude間の違いなのか、興味深いです。同じファミリーでしょ?と検証さぼると罠にはまりますね。

ChatGPTからGlaude 2に鞍替えできる?

無料枠の中でPDFを要約してくれるし、安全性を重視しているので非常に魅力的なのですが、途中で無料分が尽きて「until 9 PM」みたいにになってしまったので、無料をフル活用している私としては鞍替えしにくいです。

え?月額$20くらいさっさと払え?

ChatGPT Plusと同じ金額なんだよな。さらにGPT-4はマルチモーダルになったし、リンク先見てくれるし、そもそもBing Chat使えば無料で使えるし・・・

最近、欲しいサービスがサブスクリプションだらけで、お財布に厳しすぎます。。

まとめ

以上、Claude 2を使ってみた、でした。

ChatGPT以外のチャットAIは、少ししか触っていなかったので、面白かったです。

Poe入れて色々使えるようにしているものの、商用なら対して変わらないでしょ?と放置気味でした。

長文の本文をここまで読んでいただいたみなさま、ありがとうございました。